La salle serveur Eurogroupe Madame Vacances a demandé une restructuration totale.

En la récupérant, il y avait énormément de travail, dans sa structure et dans son fonctionnement.

En effet, le câblage était très sommaire et la partie onduleur complètement obsolète.

J’ai profité de la migration de mon infrastructure pour éclaircir la partie production.

Recentraliser la partie stockage, refaire l’ensemble du câblage réseau et électrique, avec une vraie convention de nommage, faire le tri de l’ensemble du matériel, qui pouvait être récupéré pour pouvoir concevoir un PRA, car il n’y en n’avait pas.

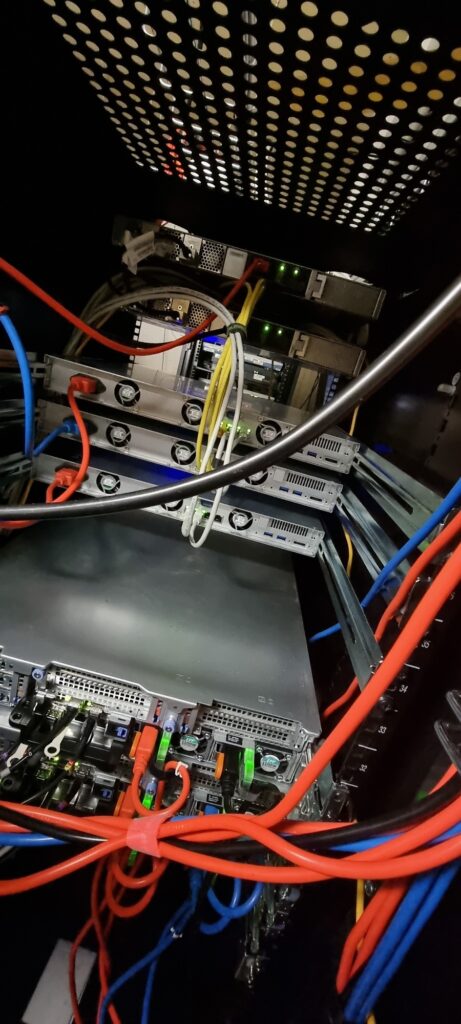

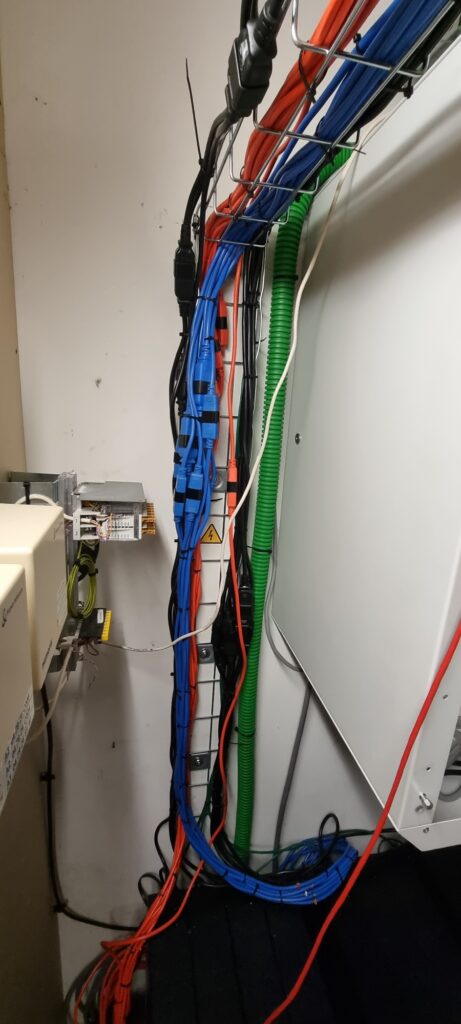

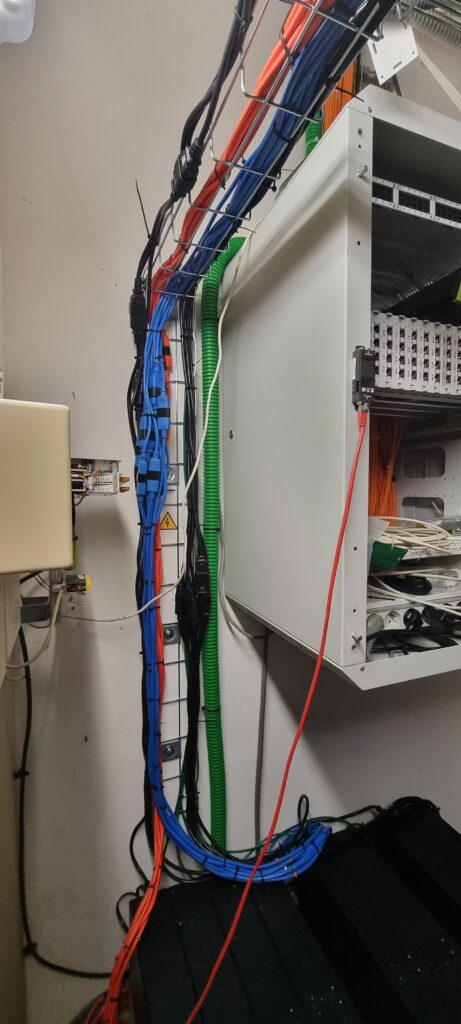

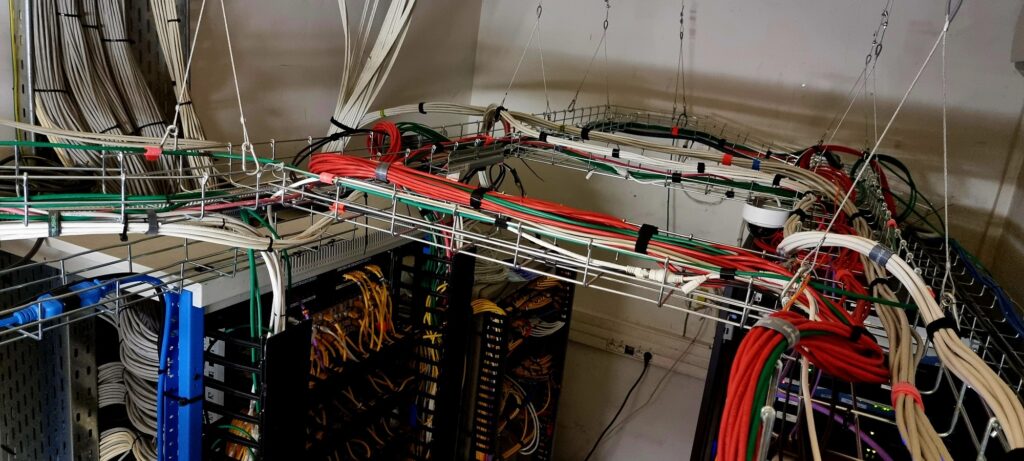

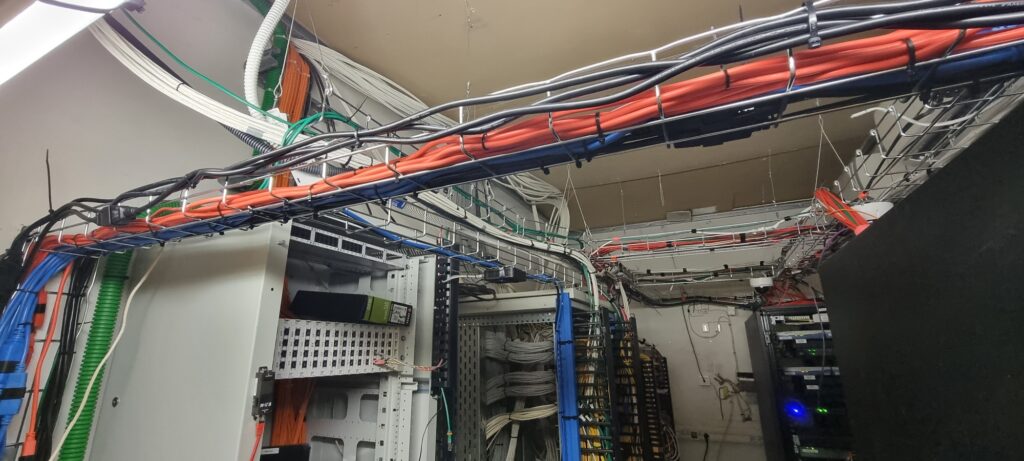

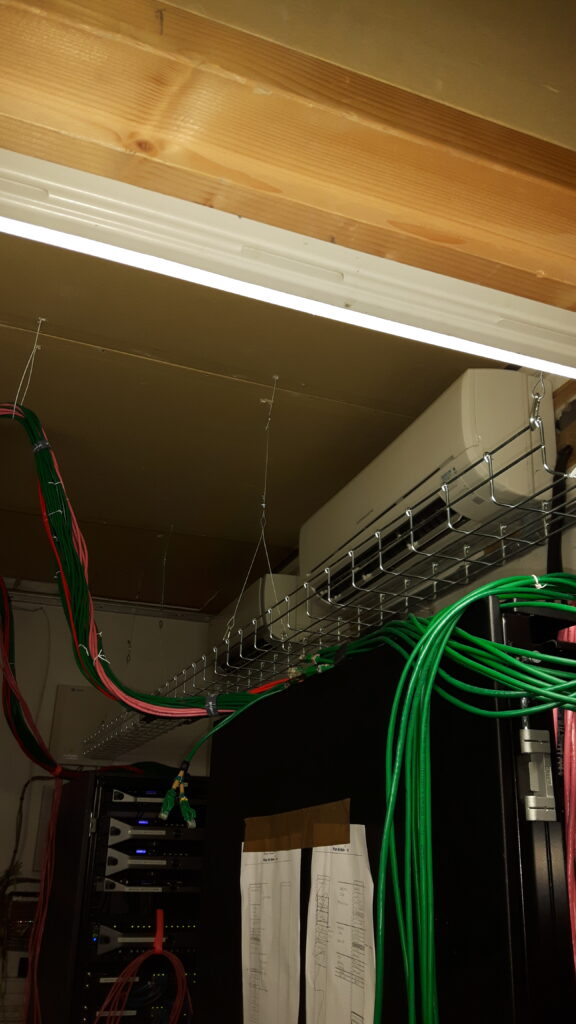

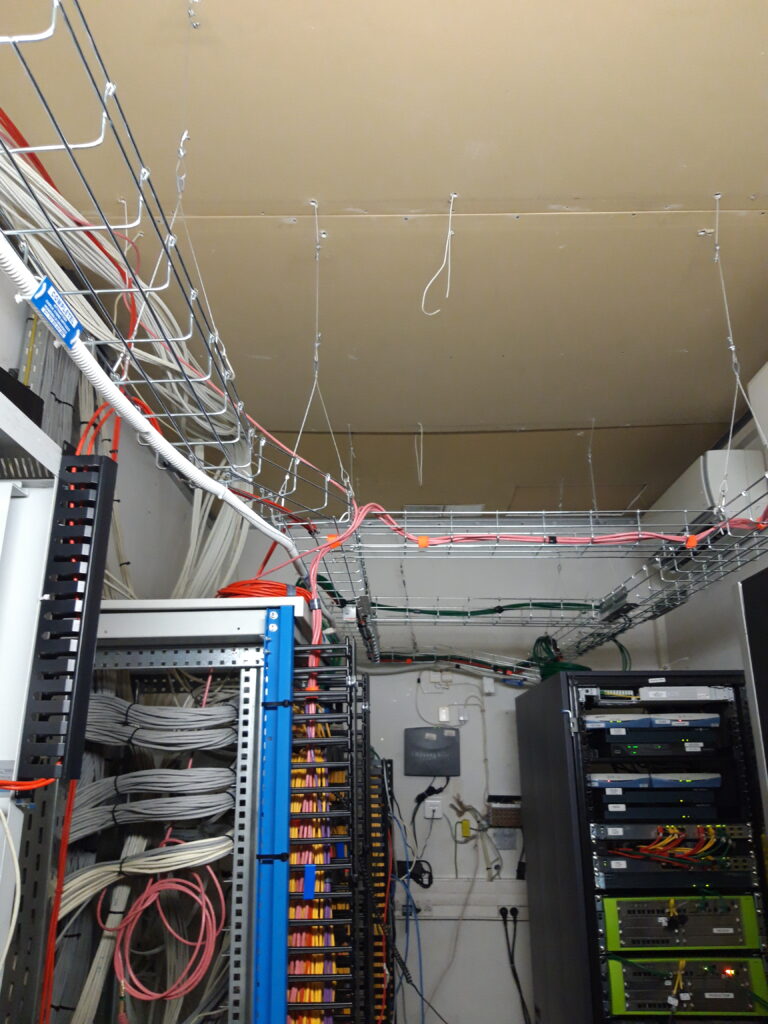

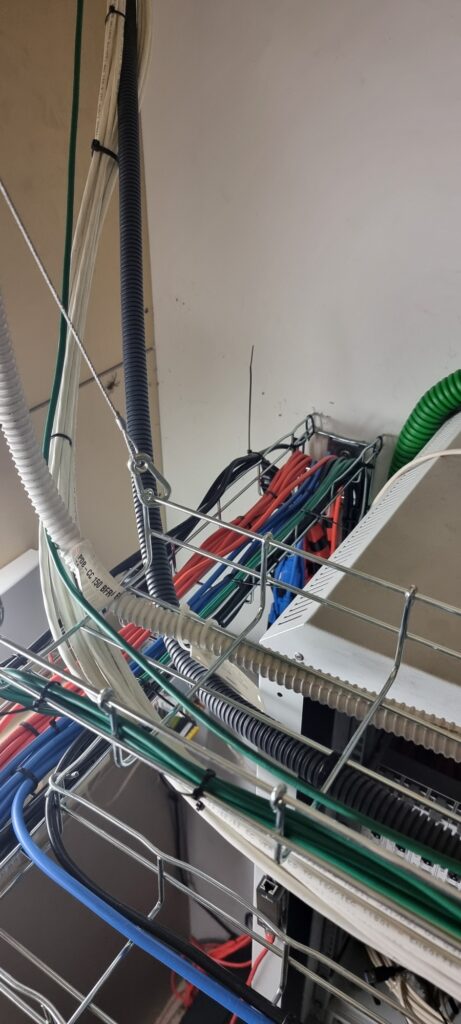

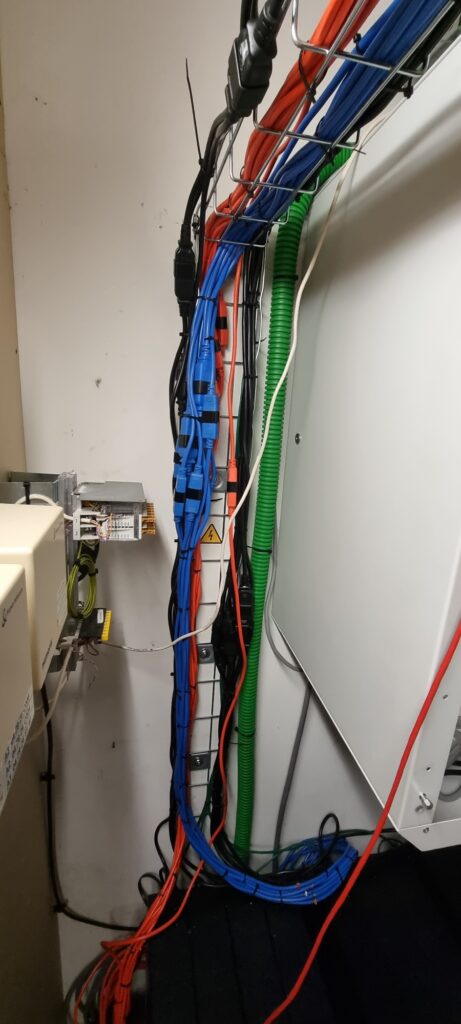

J’ai aussi profité de refaire l’ensemble des chemins de câbles pour optimiser la partie courant fort et courant faible, refait entièrement le tableau électrique local pour répartir les puissances, la partie onduleur a aussi été retravaillée, pour encaisser des maintenances, et prévoir un arrêt structuré en cas de panne.

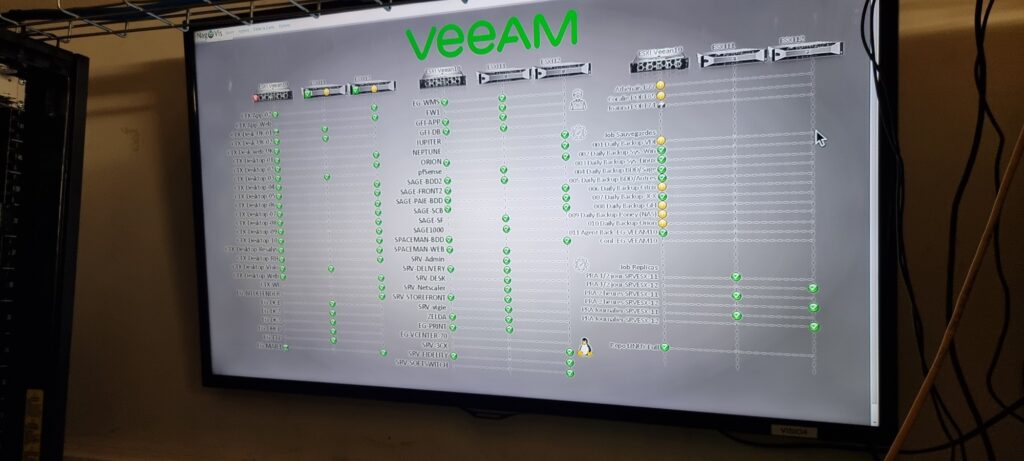

La partie PRA m’a permis d’externaliser les sauvegardes et de répliquer toutes nos machines dans un lieu sûr et prévoir un redémarrage d’urgence des parties les plus critiques.

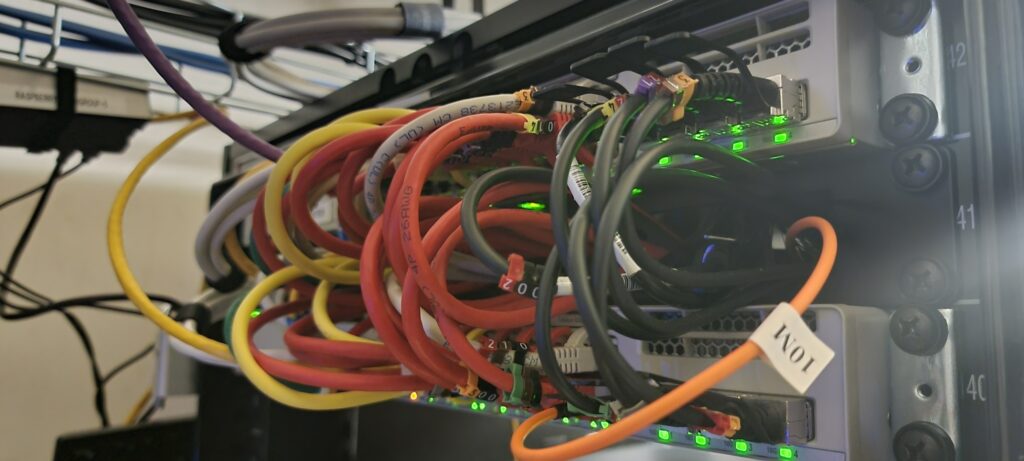

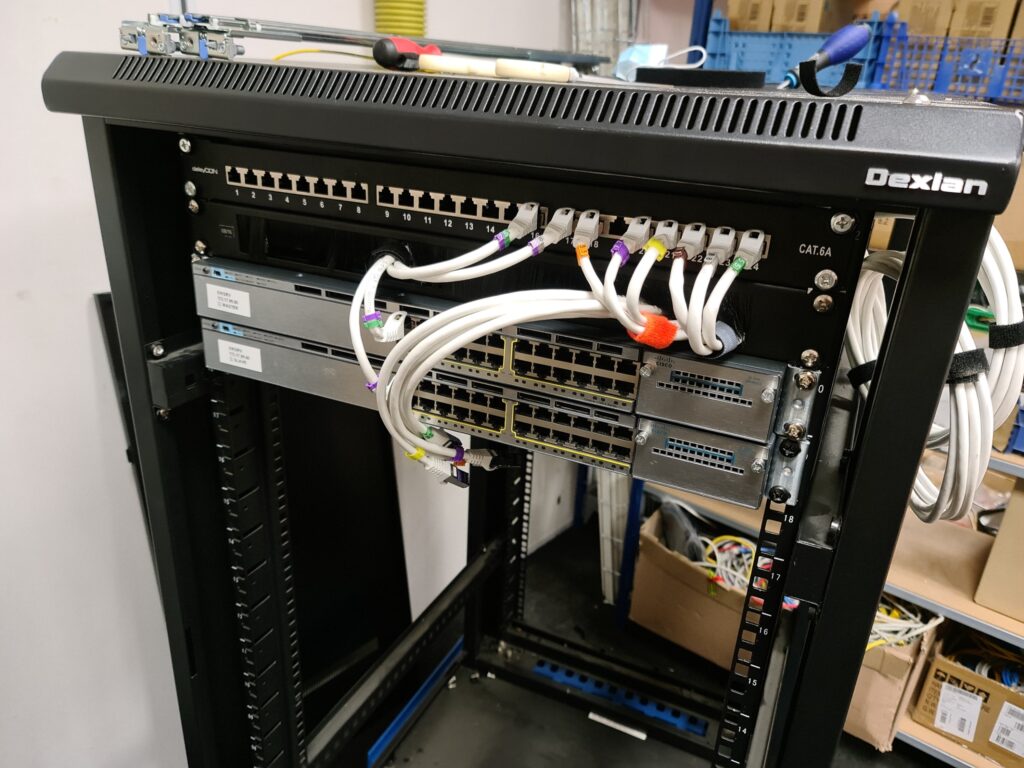

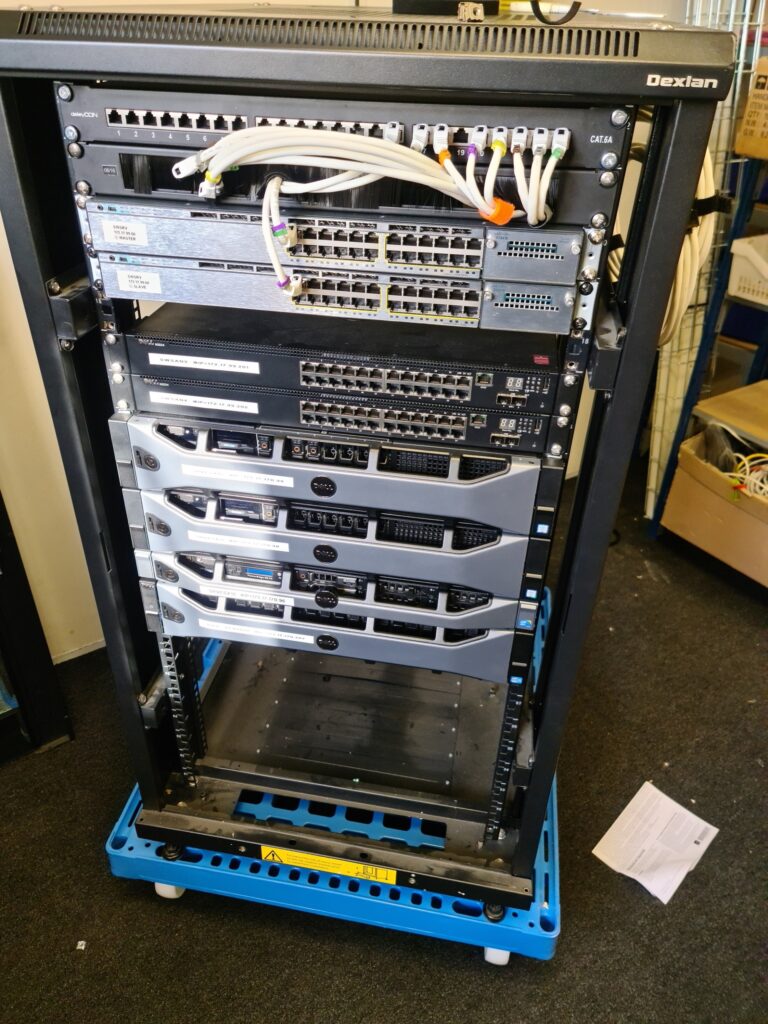

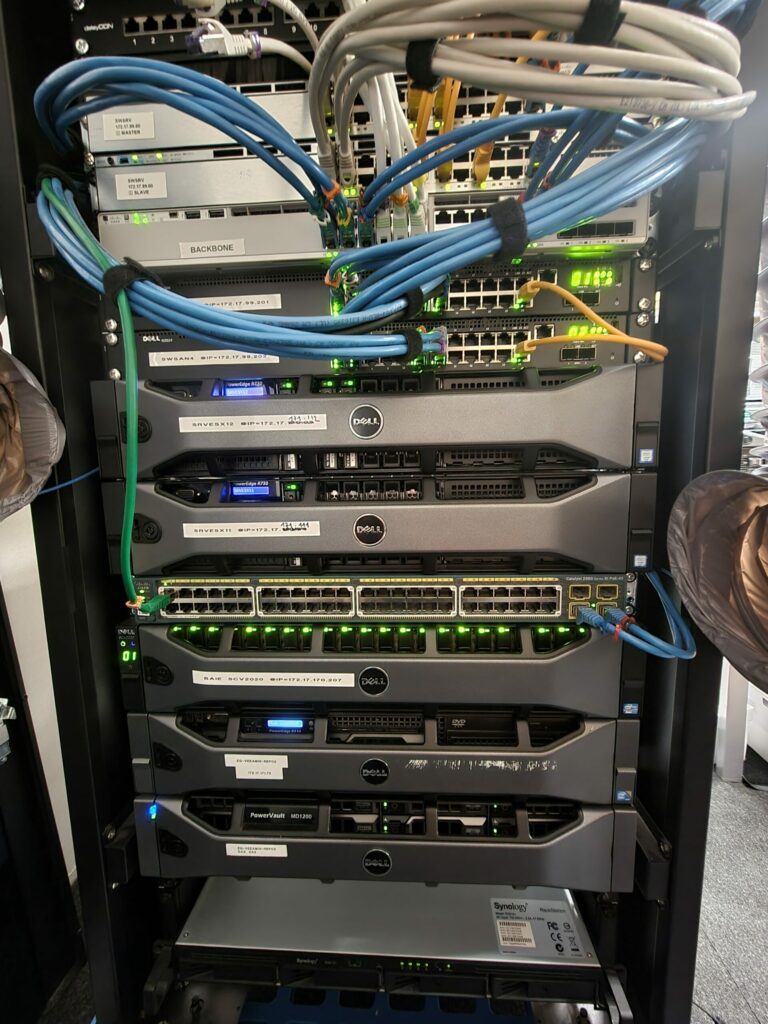

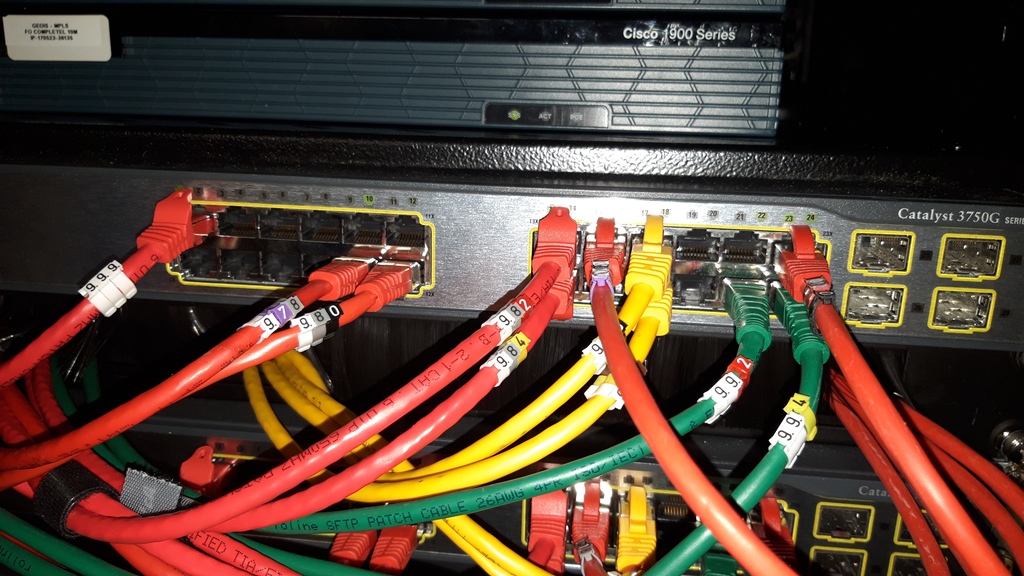

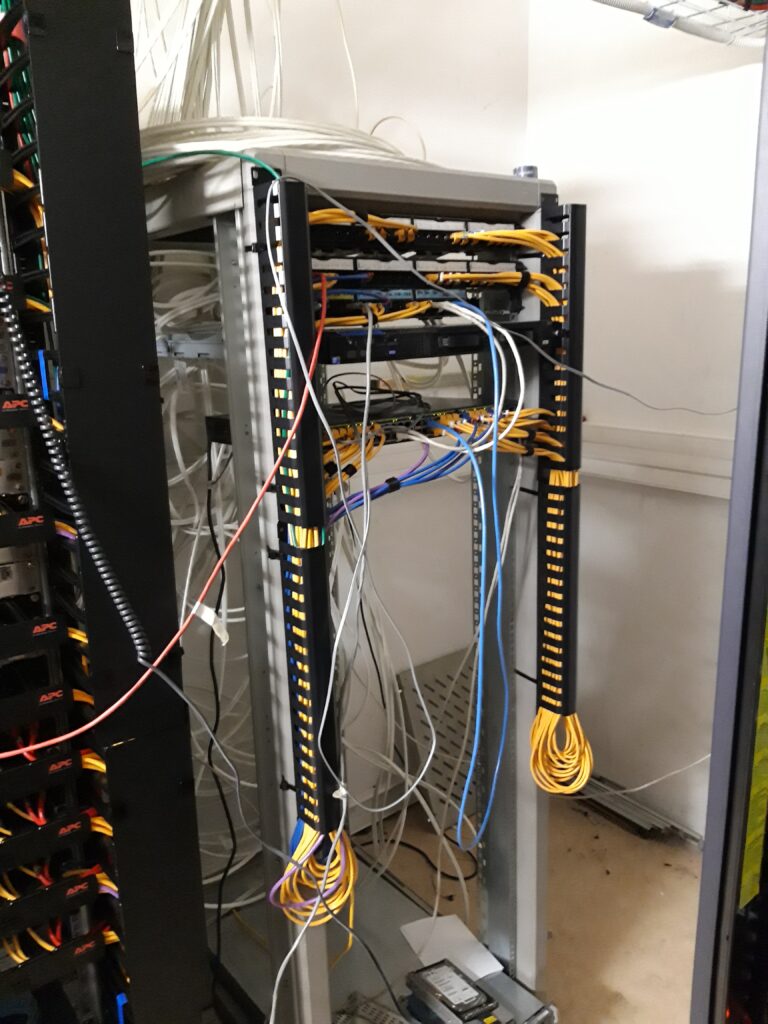

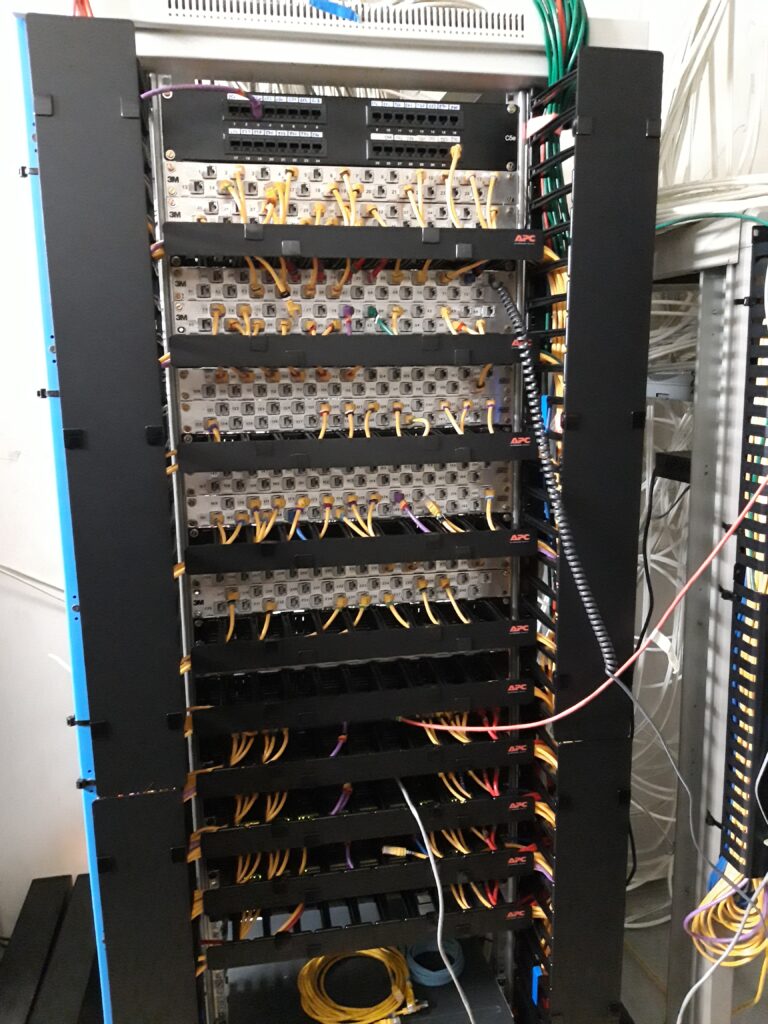

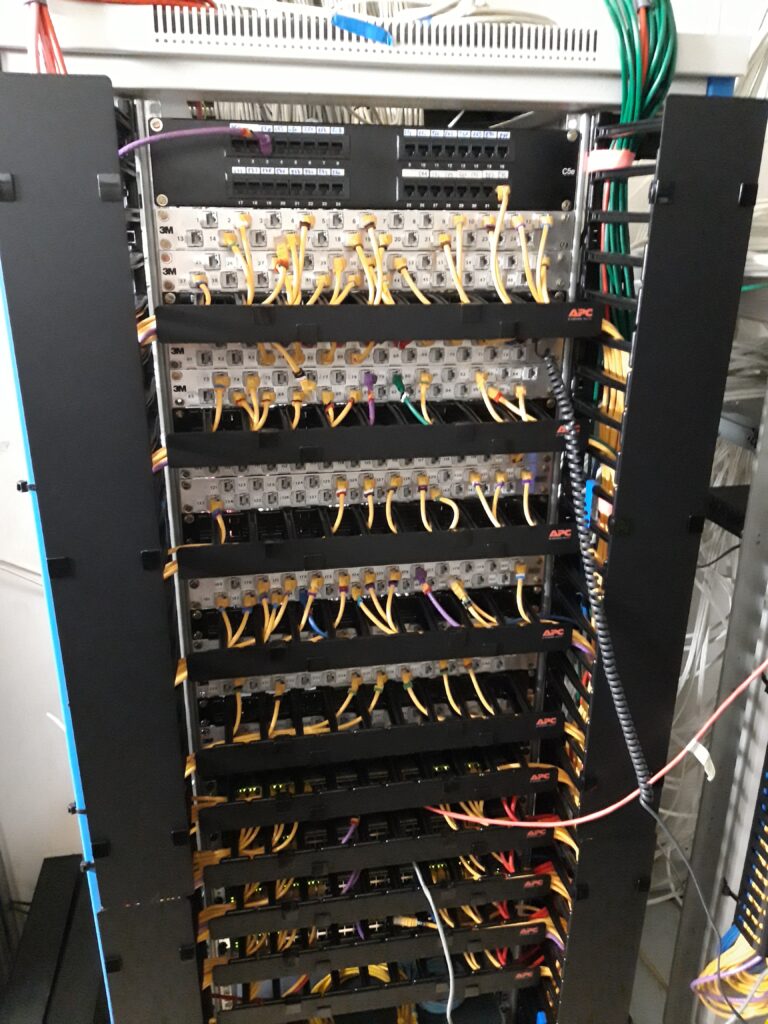

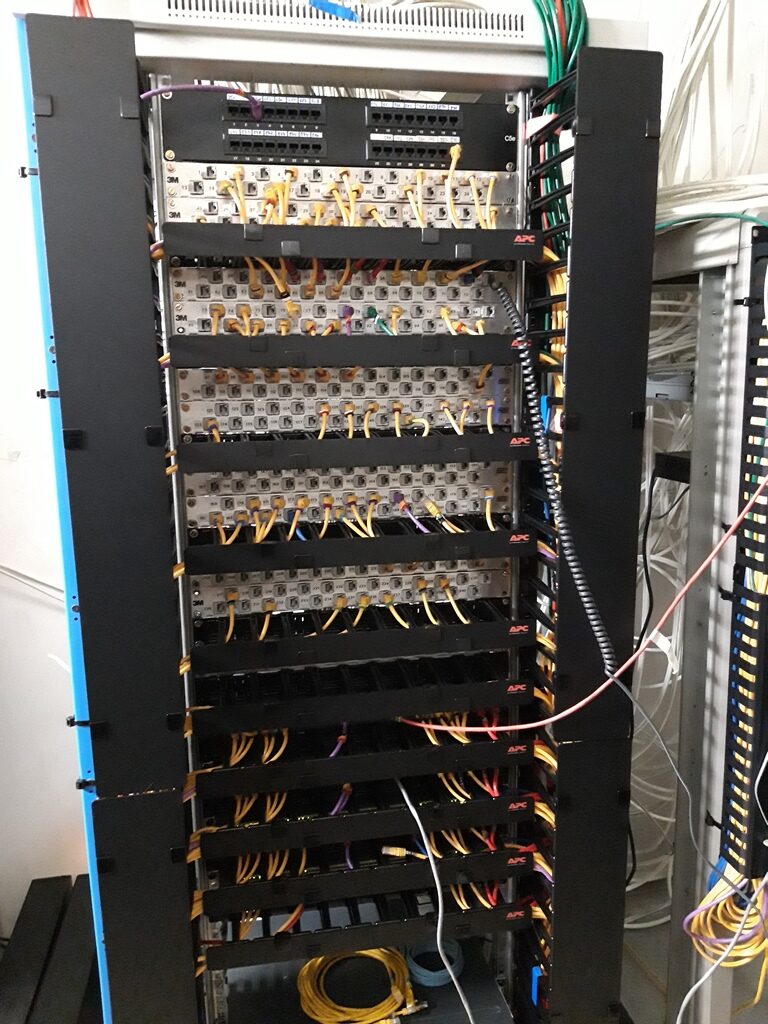

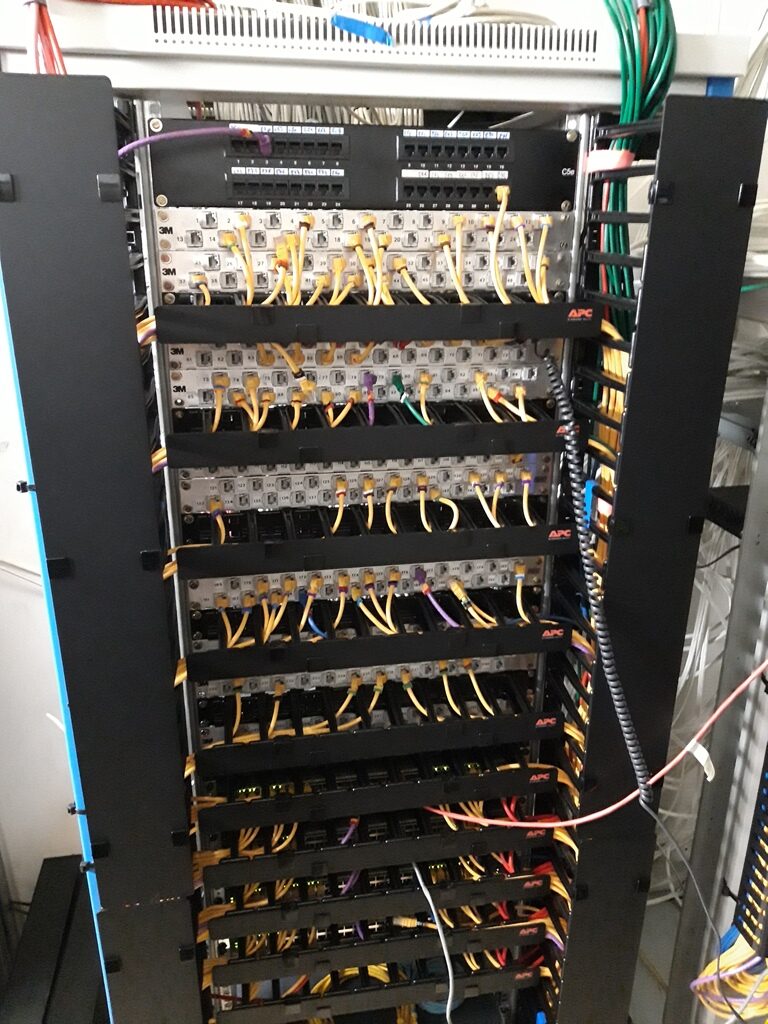

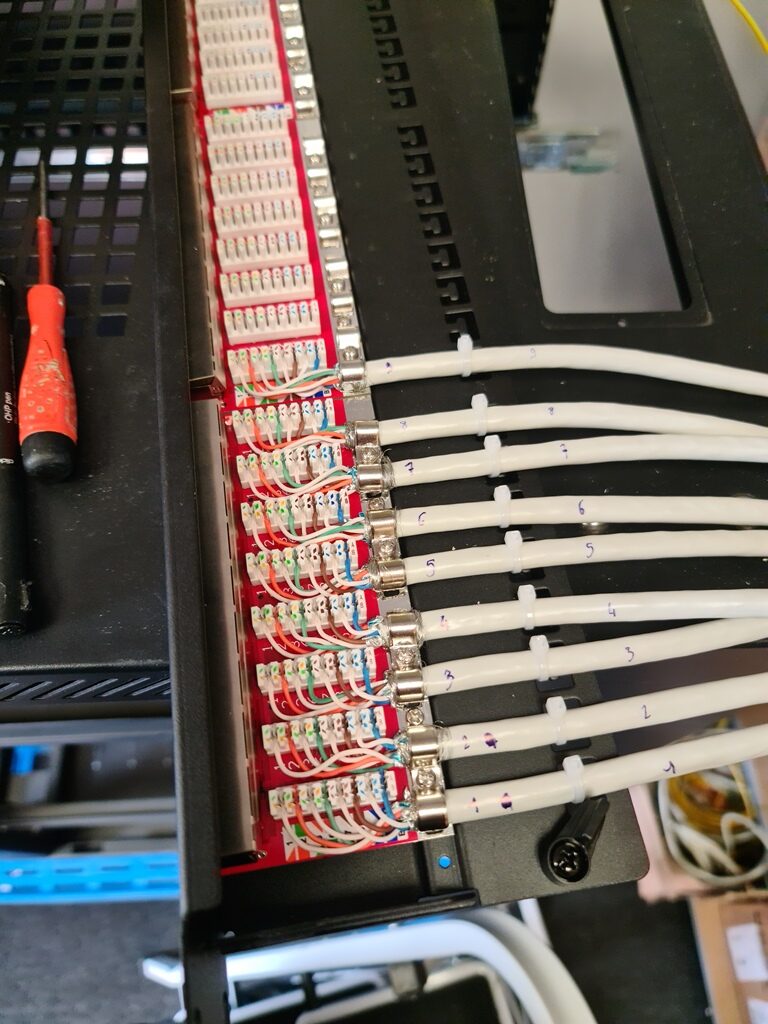

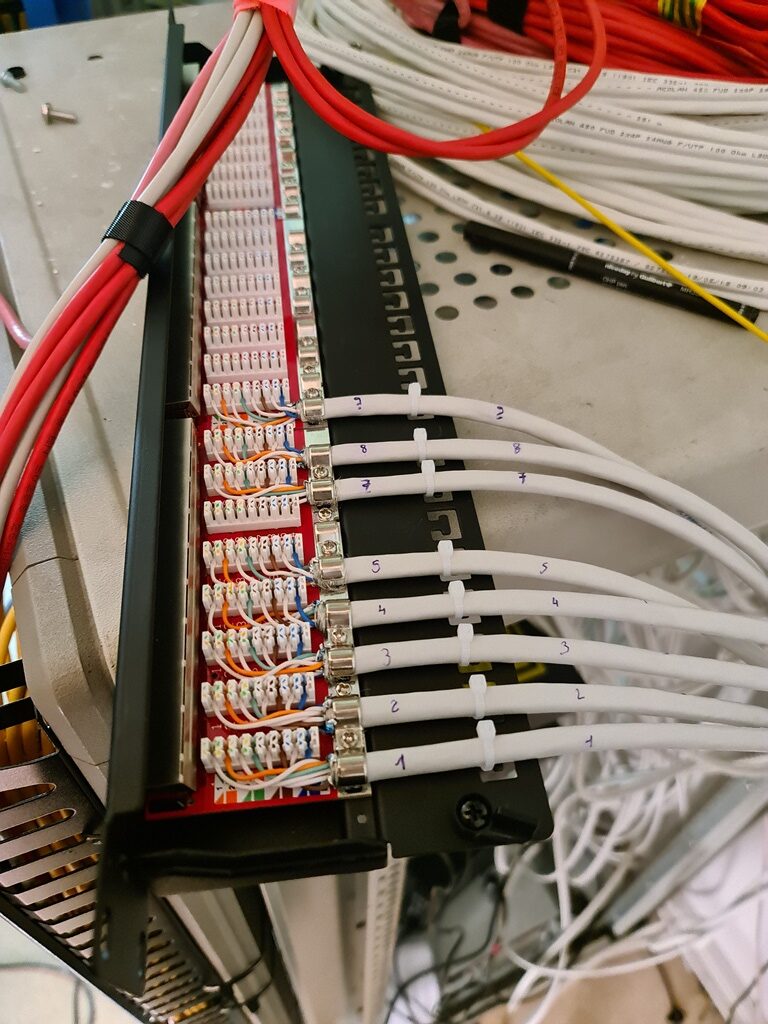

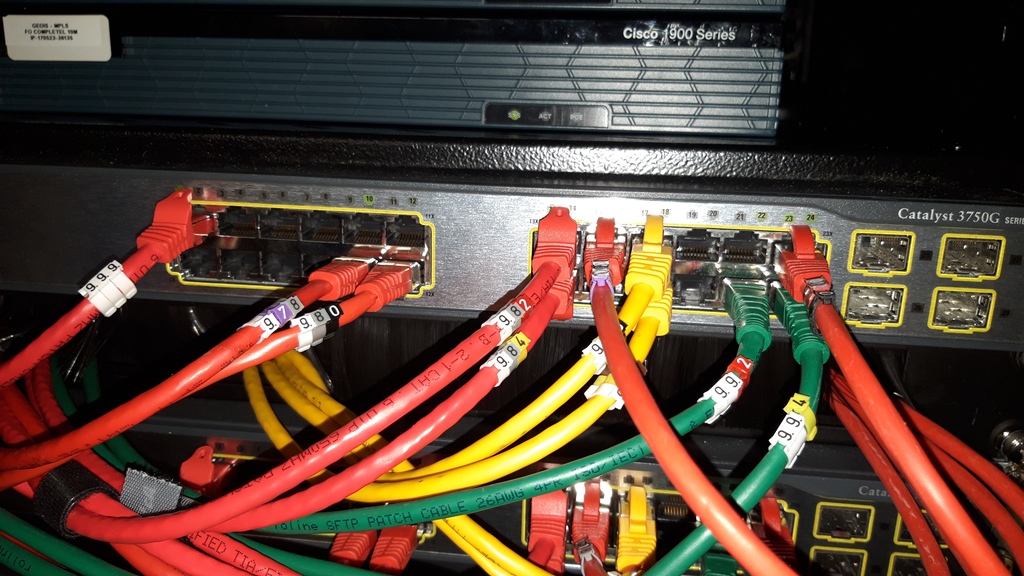

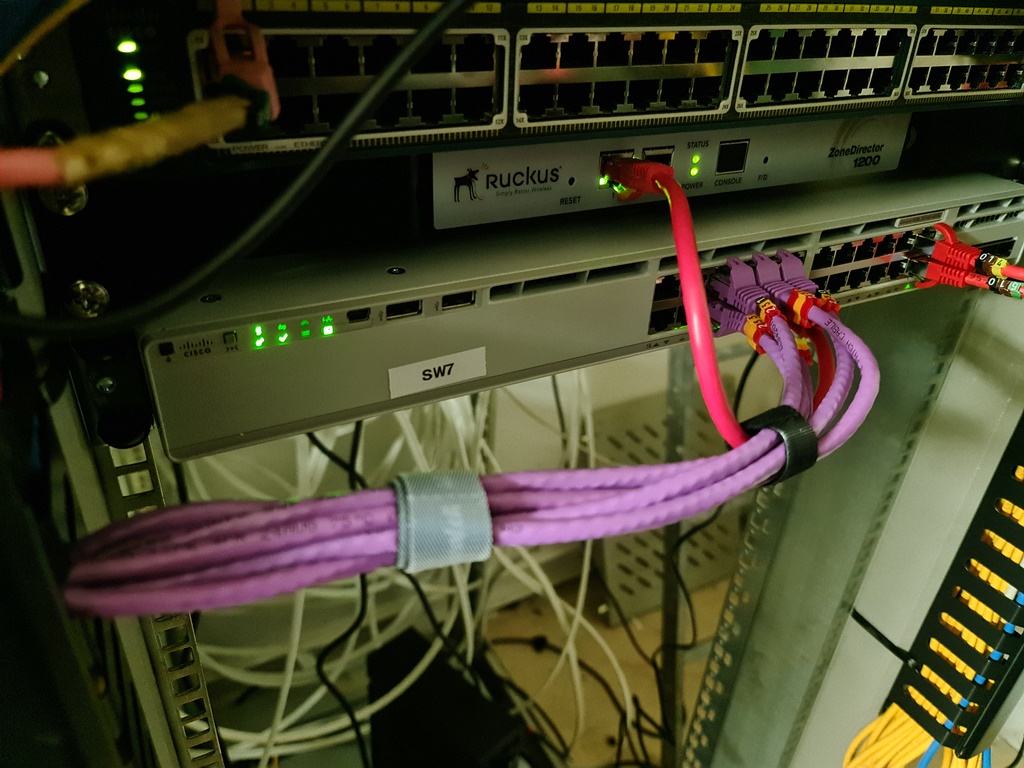

Le câblage réseau a été entièrement refait avec des câbles de qualité cat6, ils sont numérotés afin d’être schématisés.

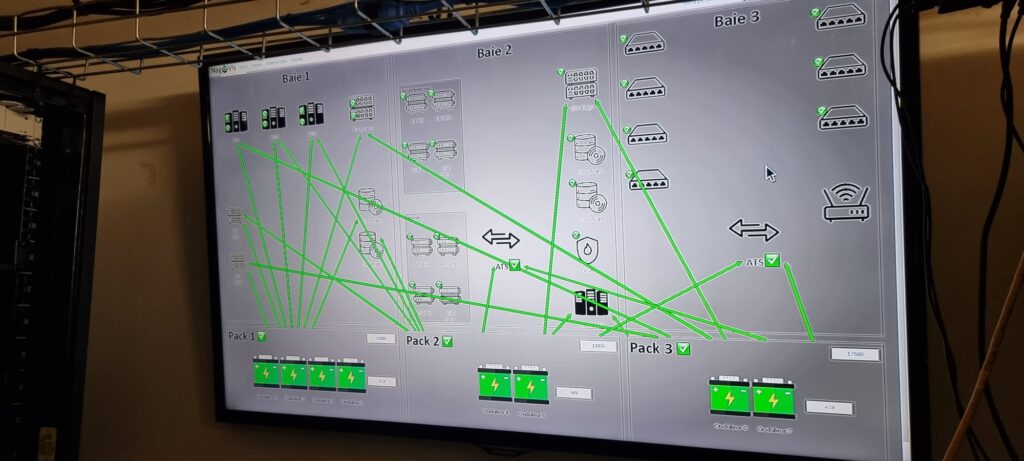

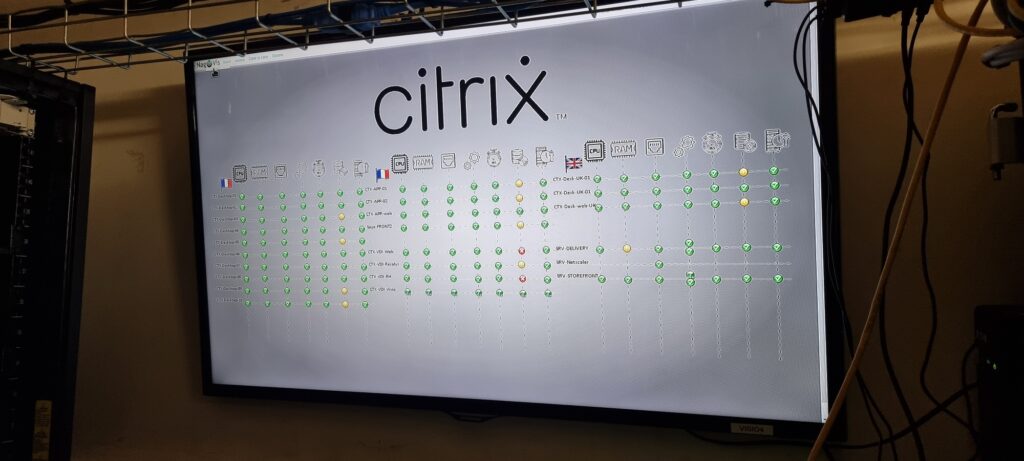

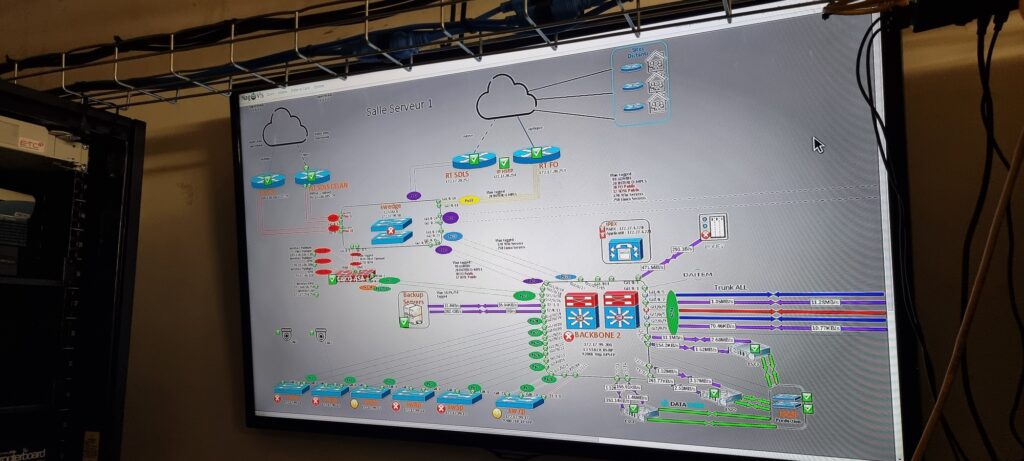

J’y ai aussi placé un écran de grande taille, pour visualiser l’ensemble de la salle serveur en direct via CheckMK, notre centre de supervision.

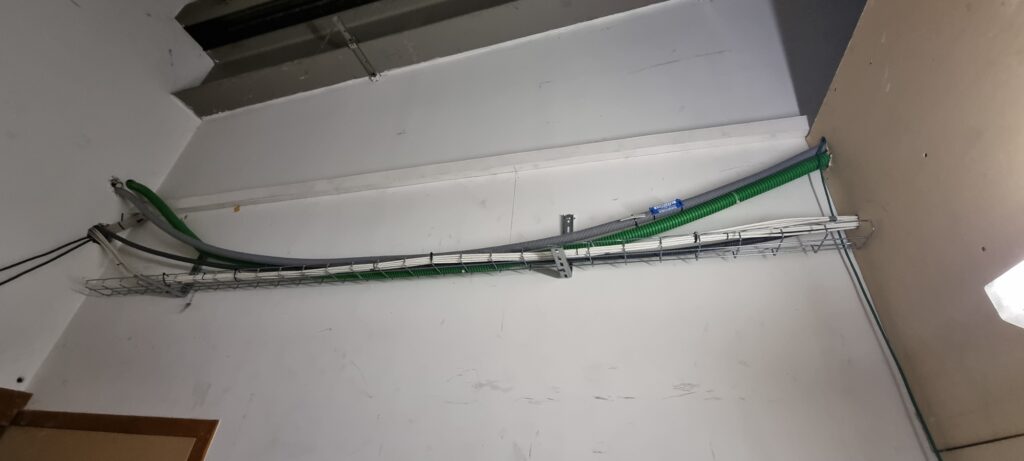

Pour finir, j’ai rajouté des fibres supplémentaires pour prévoir des liens de secours et des applications dédiées pour ne pas saturer nos liens principaux.

le projet a duré 5 ans au total.

vous pouvez retrouver ci-dessous chaque point qui a été traité dans cette salle serveur, en cliquant sur le petit +

Chaque point a été traité avec détails sur le site, vous pourrez les retrouver en naviguant dans le menu « expériences », ou en faisant une recherche globale via « lancer une recherche ».

.

Suppression Cluster de stockage physique pour bascule en 100% virtualisé

Il a fallu penser à la migration du stockage qui était composée d’un cluster physique interconnecté par une baie ISCSI.

Adapter l’hyper convergence, afin d’englober d’anciennes technologies, avec une flexibilité au maximum, ce que DATACORE nous a permis de faire.

La pérennité des données a pu être assurée à son maximum grâce à cette technologie et nous a aussi permis d’externaliser les données à l’instant « T « de l’ensemble du stockage tant sur la partie Data user que sur le stockage serveur. ..

Création PRA

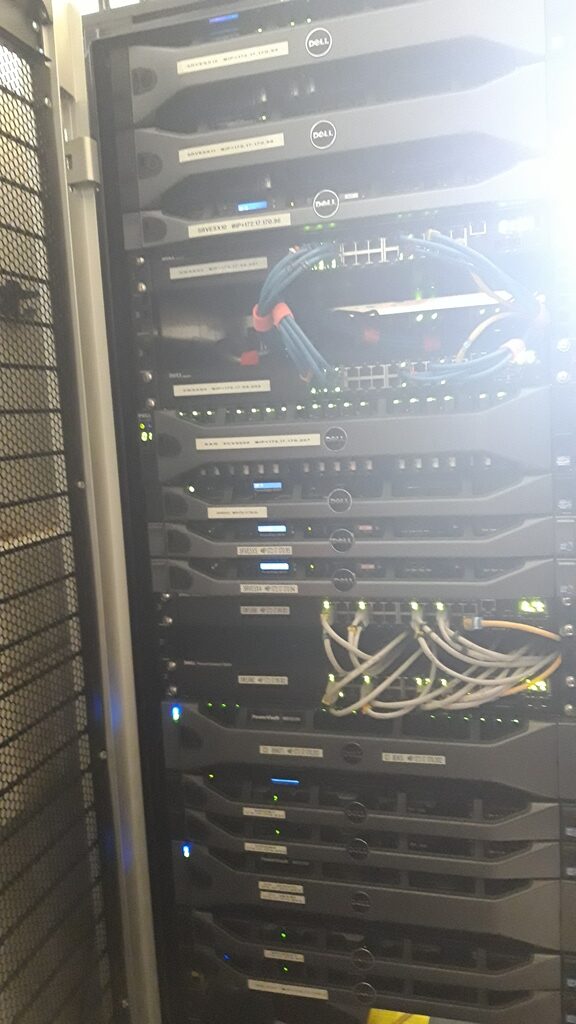

J’ai pu récupérer énormément de matériel lors de la restructuration.

En effet, mes ESXi étaient loin d’être obsolètes à 100 %, j’ai pu renouveler mes contrats de maintenance DELL encore quelques années, puis avec des brokers, ce qui m’a permis de concevoir un PRA et permettant la remise en route de 70 % de l’infrastructure en cas d’erreur grave.

Il nous a aussi permis de répliquer toute la partie VEAAM backup, et de dédoubler nos races Synology.

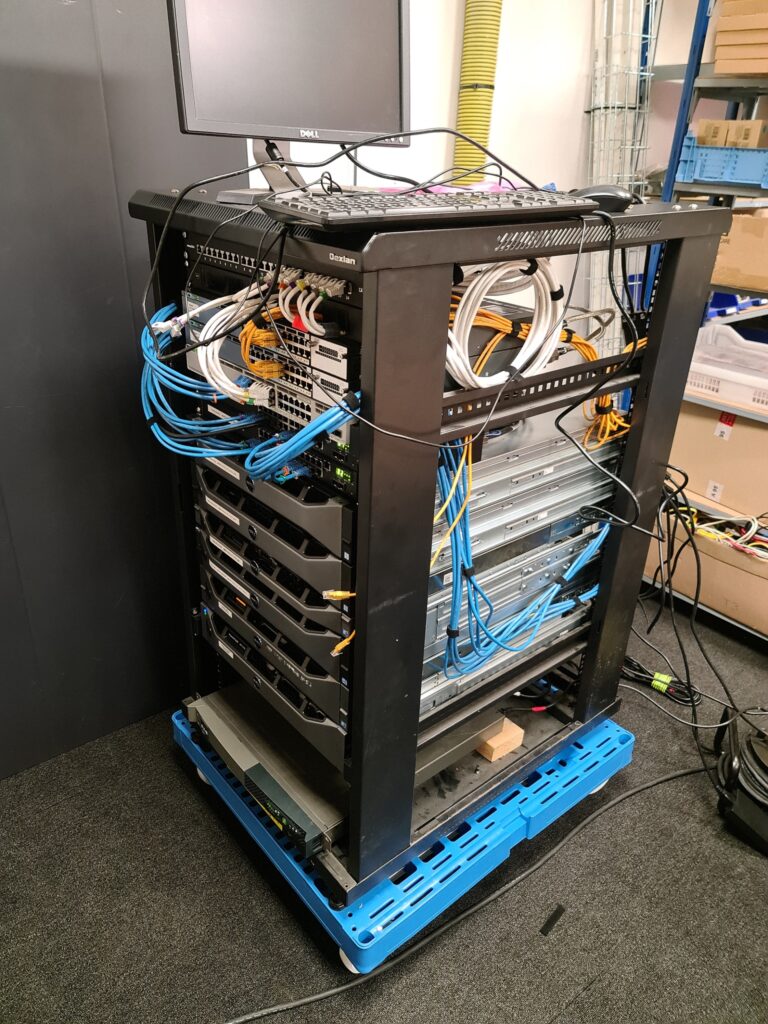

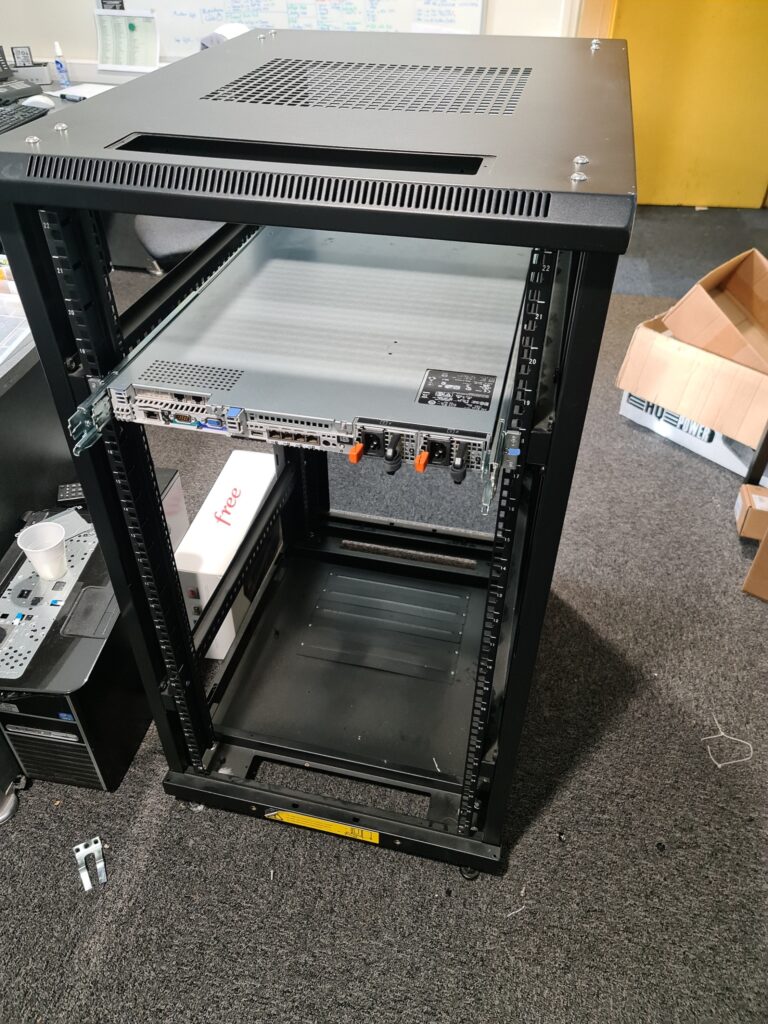

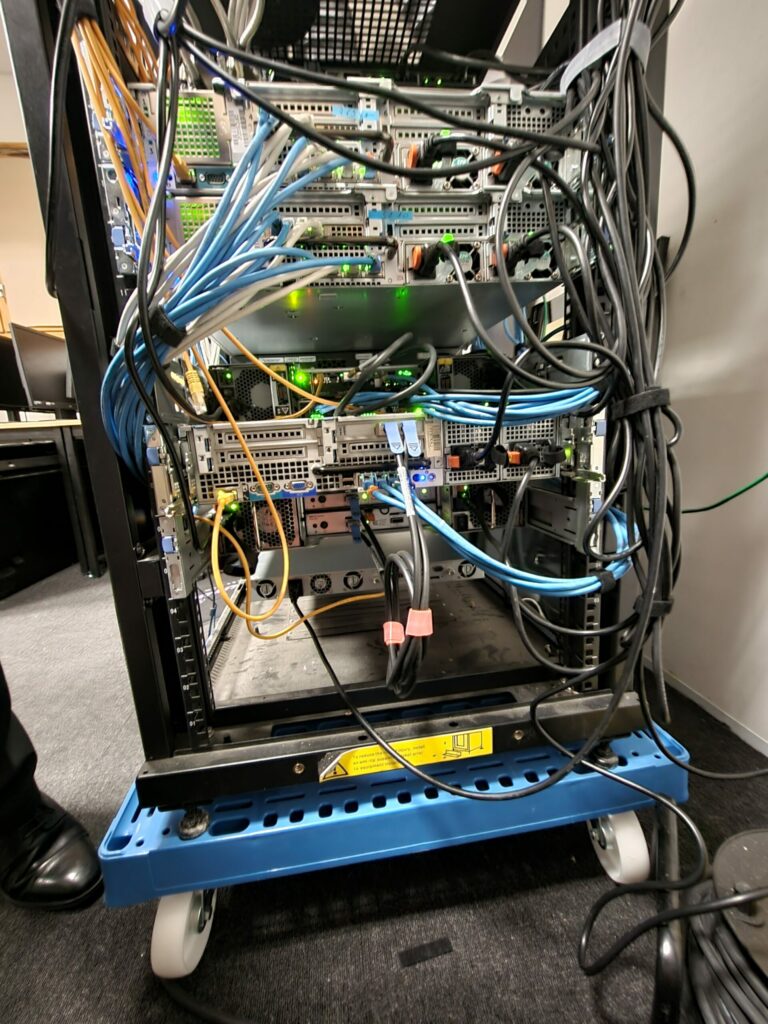

J’ai monté cette petite infrastructure sur une demi baie, posée sur un plateau roulant pour lui permettre de bouger facilement vers une autre salle, si besoin. ..

Bascule Cluster Unify vers 3CX

La bascule de notre téléphonie a été un grand moment pour moi, elle m’a demandé beaucoup de travail et de schématisation, tant sur la partie système, que sur le réseau.

Nous avions deux serveurs physiques de marque Unify fonctionnant en quelque sorte en cluster, il m’a fallu prévoir toute la partie réseau et firewall, et une études du 3CX.

Elle m’a demandé la création d’un dossier complet d’une soixantaine de pages composé de la partie technique physique, virtualisé, gestion des flux, et gestion du call center.

Ce projet a duré 6 mois, actuellement le groupe utilise 3CX et JUSAN pour notre Call Center. ..

Installation fibre FFTH

J’ai tiré tout dernièrement une fibre optique FFTH afin d’alimenter un routeur MIKROTIK pour prévoir une patte WAN de secours, mais aussi de pouvoir l’utiliser pour des applications dédiées comme le Cloud, VPN… afin d’éviter de saturer notre fibre optique FFTO et de la prioriser pour des applications plus critiques. ..

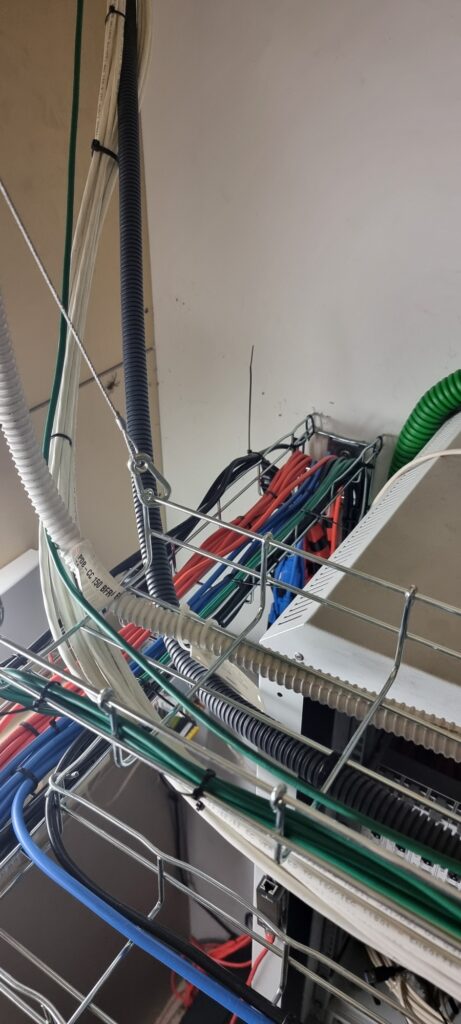

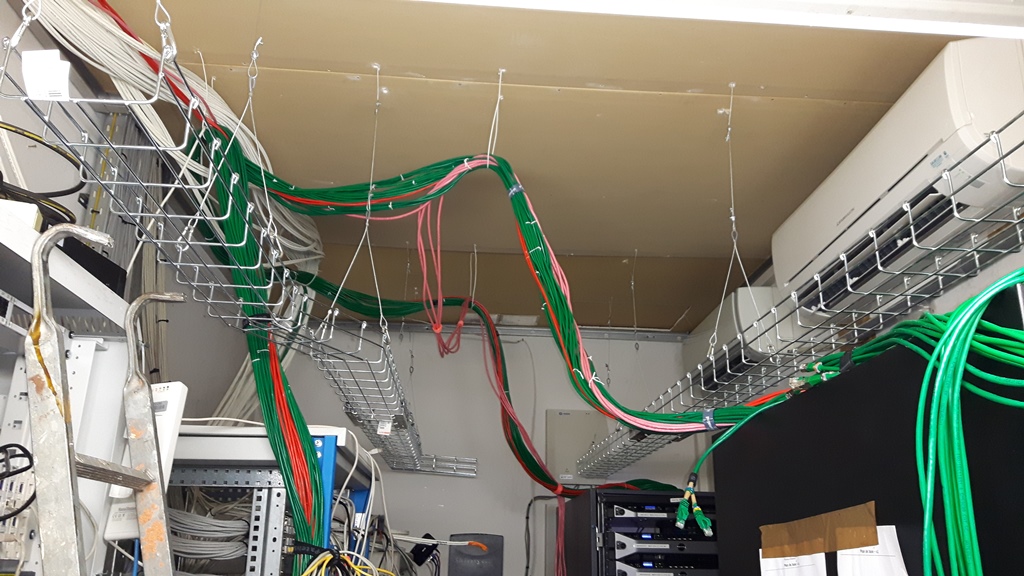

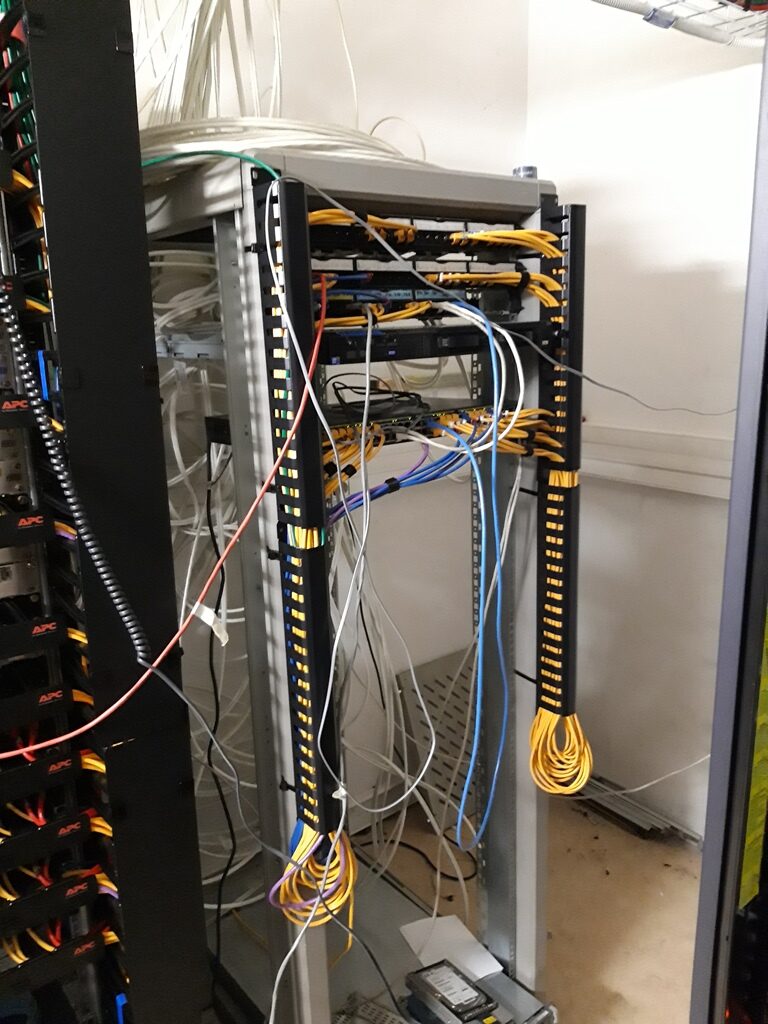

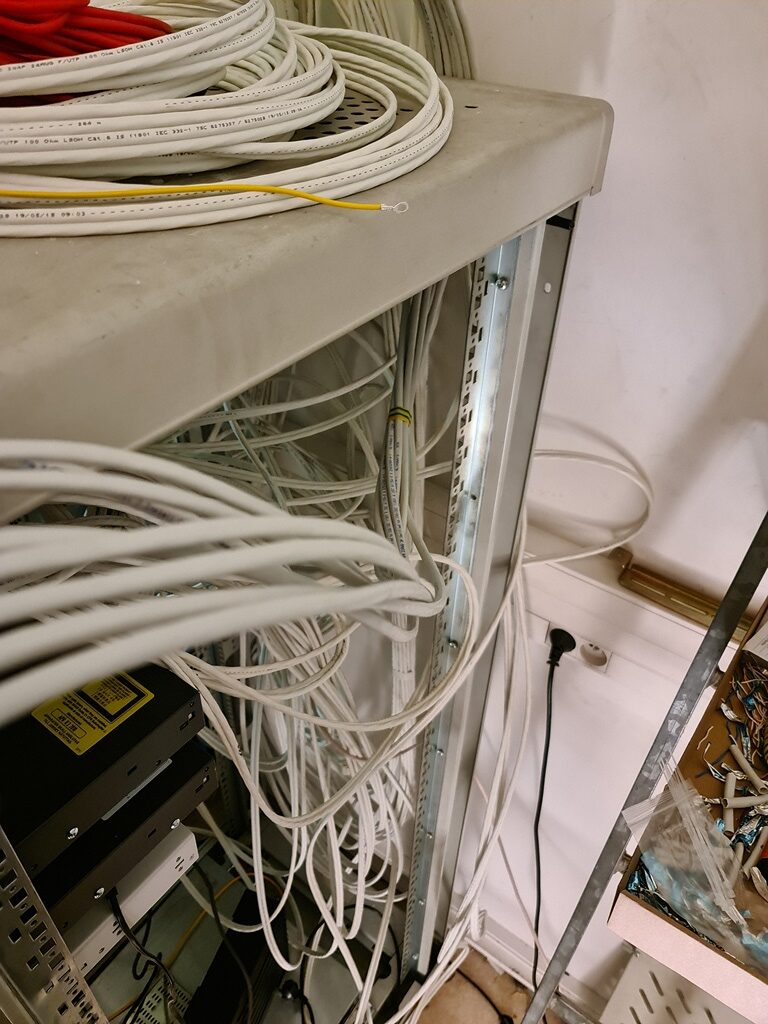

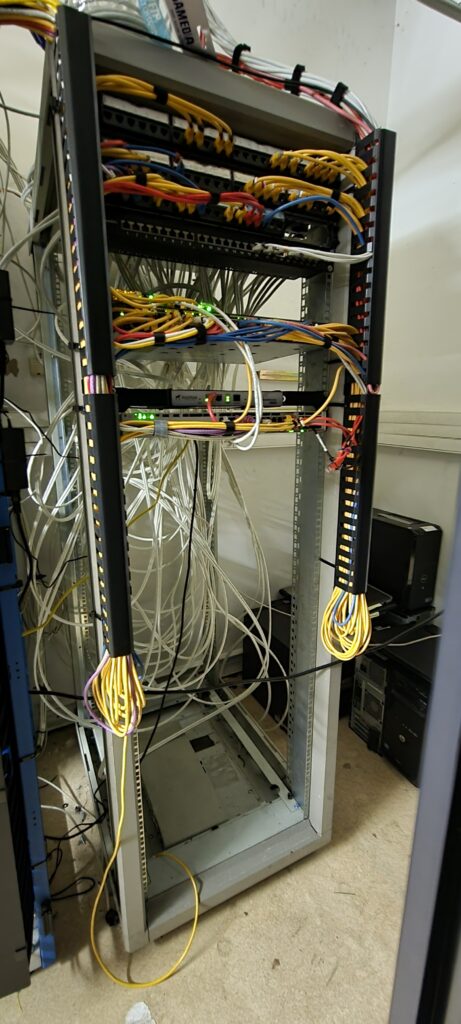

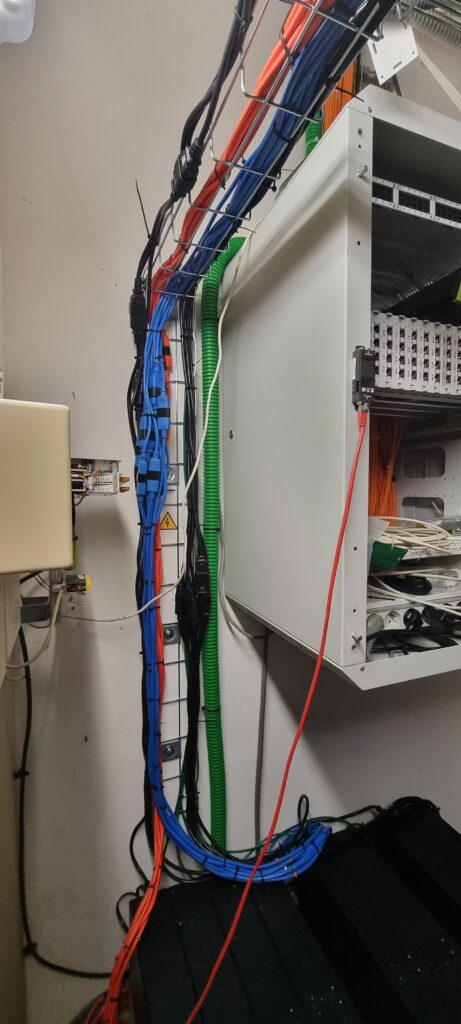

Mise en place de nouveaux chemins de câbles

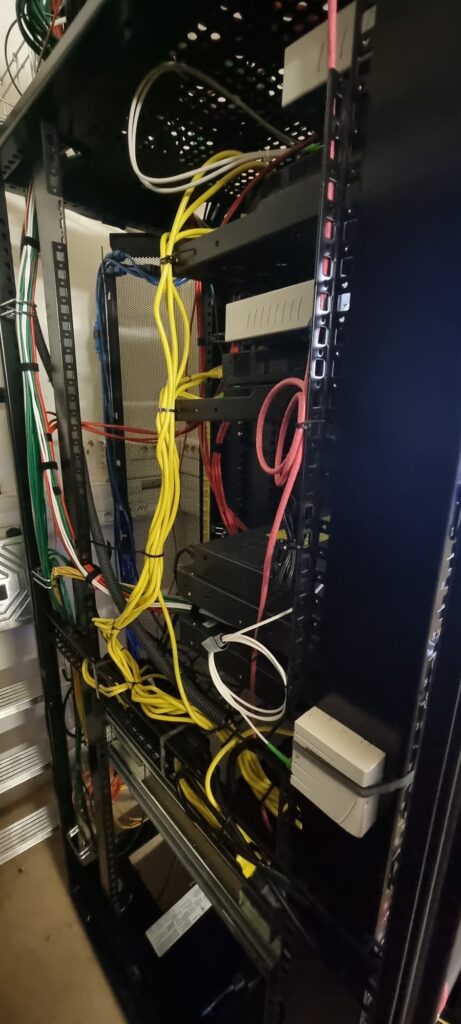

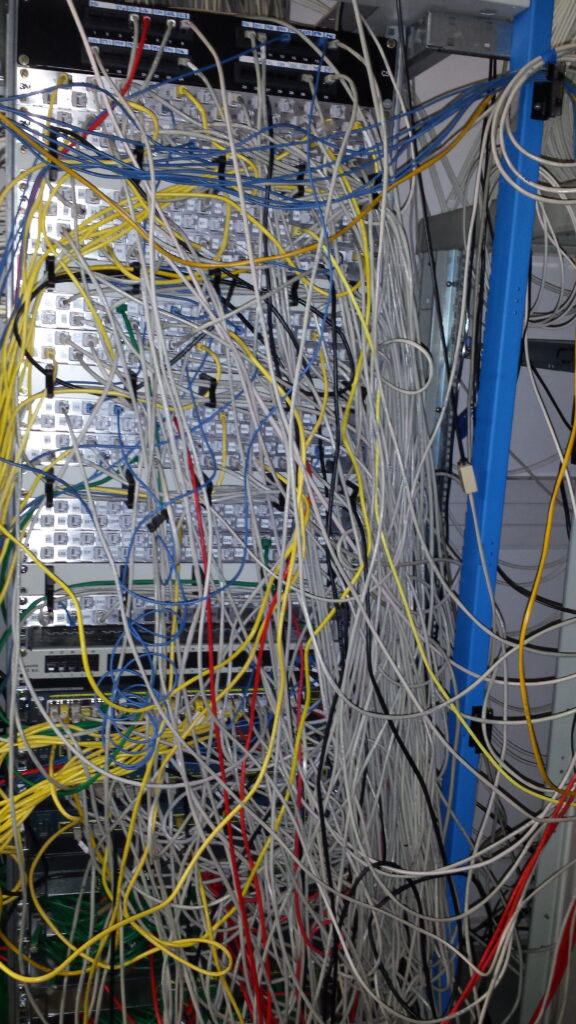

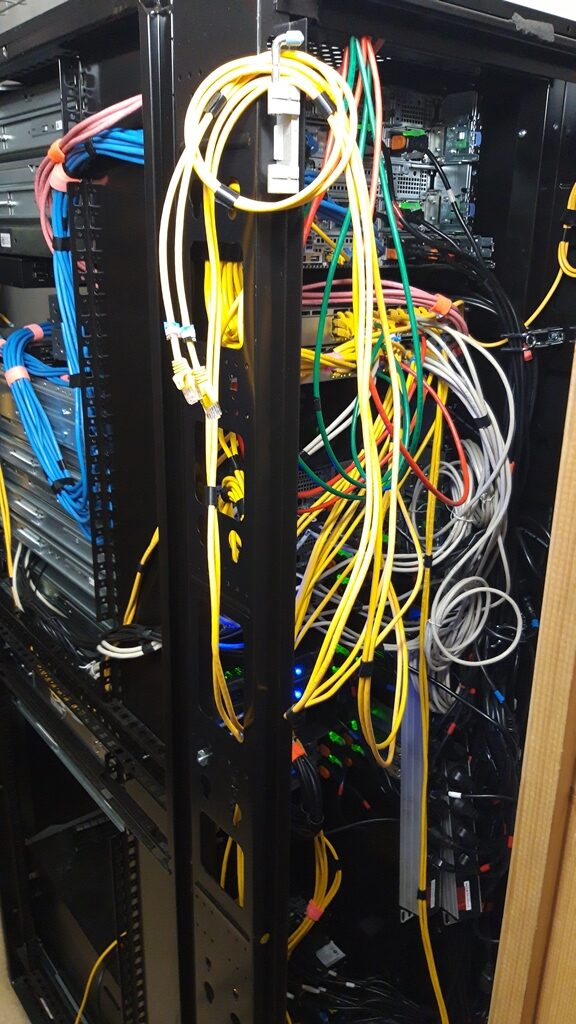

Comme vous pourrez voir sur les photos, en arrivant, la salle serveur était très mal en point, les câbles étaient posés à même le sol, et les câbles d’interconnexion entre baies étaient suspendus au plafond par des fils électriques.

Les câbles réseau étaient en mauvais état, parfois abîmés, il m’a fallu entièrement décortiquer ceux qui étaient inutiles, car rien n’a été retiré au fur et a mesure du temps, tout était empilé comme un « mille-feuilles ». ..

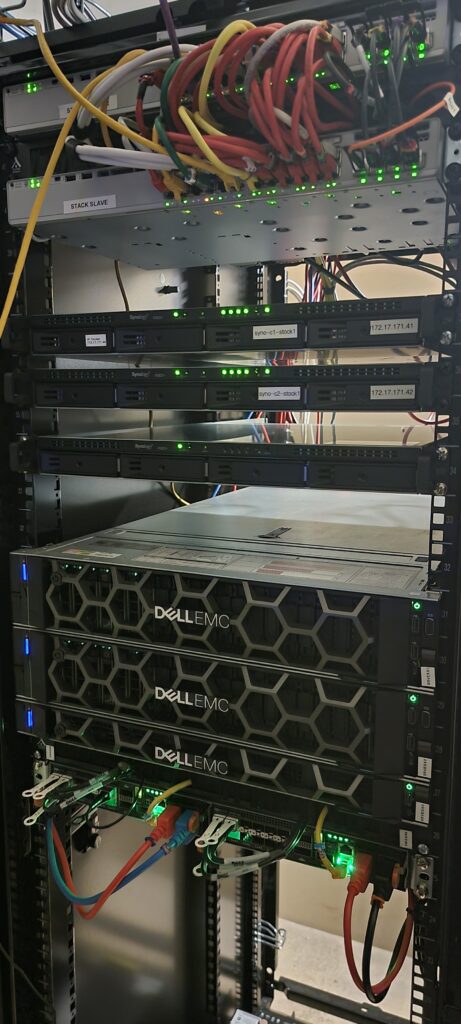

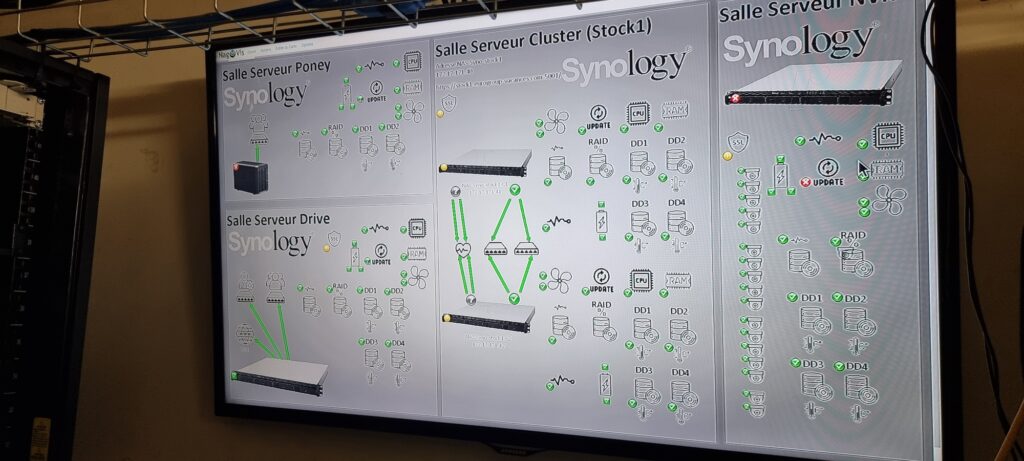

Mise en place d'un Cluster Synology

Le stockage DATACORE est vraiment une solution parfaite mais reste chère.

Pour la partie donnée froide, j’ai préféré investir dans des racks Synology pour y stocker un maximum de données.

Cependant pour plus de sécurité, j’ai mis en place un cluster qui nous fournit les partages réseau les plus critiques.

Afin d’assurer encore plus de sécurité, j’ai mis en place un autre Synology dédié pour appliquer des snaps réguliers de l’ensemble de nos données avec des sauvegardes immuables. ..

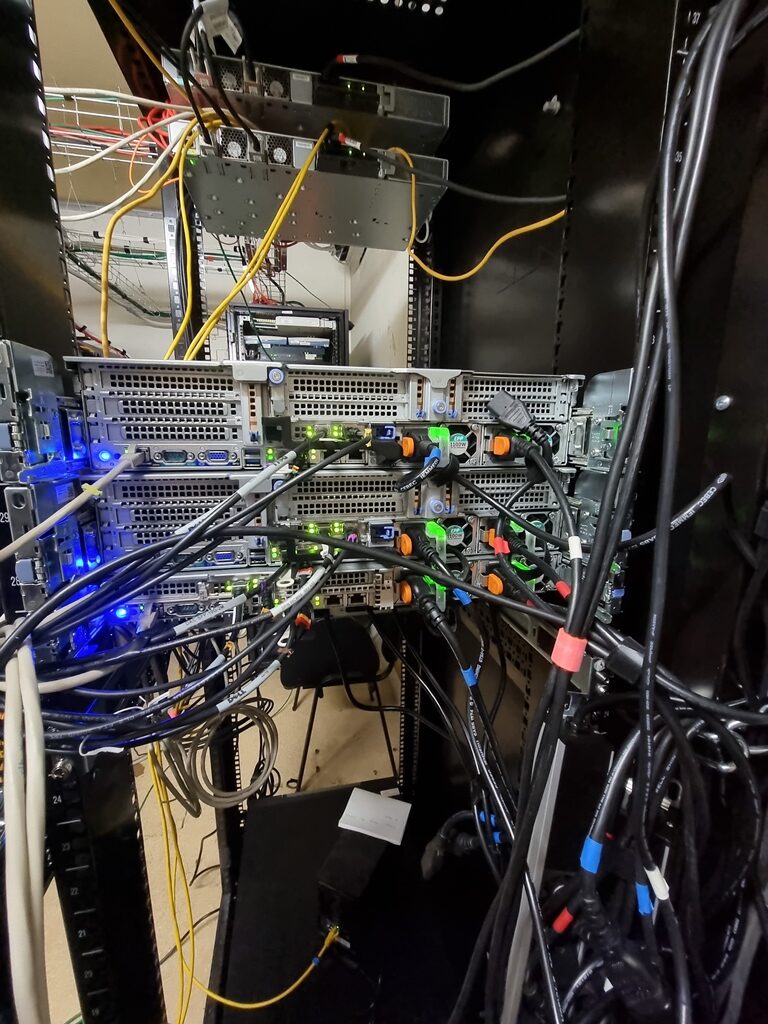

Mise en place de quatre nouveaux ESXi de production

Comme tout changement d’infrastructure, il est bon de penser au changement de ses serveurs de production.

Après avoir analysé l’ensemble des besoins du groupe et l’évolution globale à prévoir sur 5 ans, j’ai investi sur trois nouveaux serveurs de production, se qui nous permet de faire tourner au total 80 serveurs virtualisés pour subvenir aux besoins du groupe.

j’ai aussi investi sur un serveur de sauvegarde qui nous a permis d’avoir des nouvelles garanties DELL, et d’avoir par la même occasion un PRA avec les anciens serveurs à moindre frais avec des garanties DELL extensibles. ..

Installation Synology pour de la vidéo surveillance

Afin d’assurer plus de sécurité et d’après mes expériences d’électricien, j’ai équipé l’ensemble du bâtiment en vidéo surveillance avec au total une vingtaine de caméras, j’ai tiré avec Jordan l’ensemble des câbles réseau, tous reliés par des switchs POE dédiés pour l’extérieur, afin d’éviter tout dommage en cas de court-circuit sur des caméras extérieures et afin de ne pas impacter notre réseau interne.

j’ai mis en place un serveur Synology équipé de SSD grande capacité, pour encaisser la 4K de chacune des cameras. ..

restructuration du réseau physique

En arrivant chez Madame Vacances la salle serveur n’était pas en bon état, il a fallu restructurer l’ensemble, schématiser câble par câble, refixer des structures sur les baies en elle-même et supprimer ce qui n’était plus utile.

J’ai aussi refait tous les chemins de câbles en direction des fibres optiques extérieures qui pendaient par des câbles électriques.

J’ai tout schématisé pour ne pas faire de bêtises, puis retirer l’ensemble des câbles de façon correcte et racheter des centaines de câbles en catégorie 6.

J’ai refait tout le câblage des baies serveurs, j’en ai profité pour moi-même fixer les chemins de câbles afin de maintenir les fibres optiques, les câbles de réseau, et les alimentations électriques. ..

Etat de la salle serveur avant mon arrivée

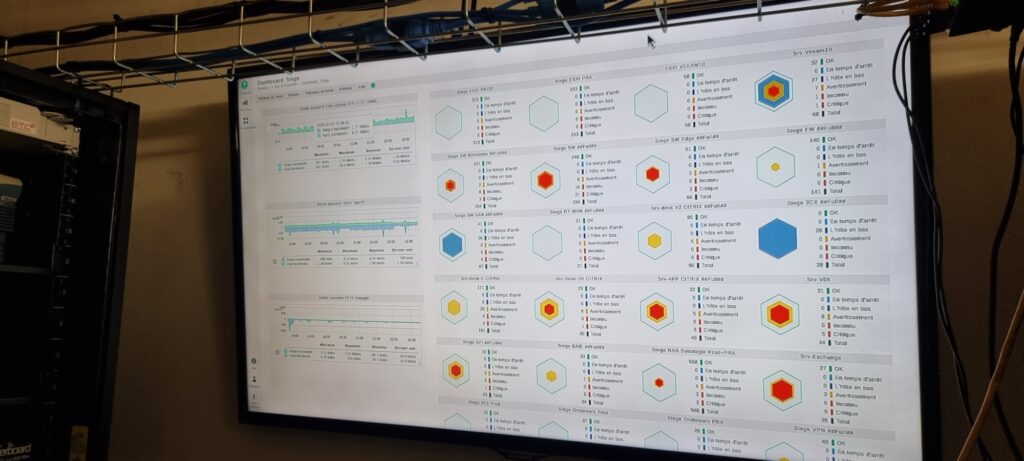

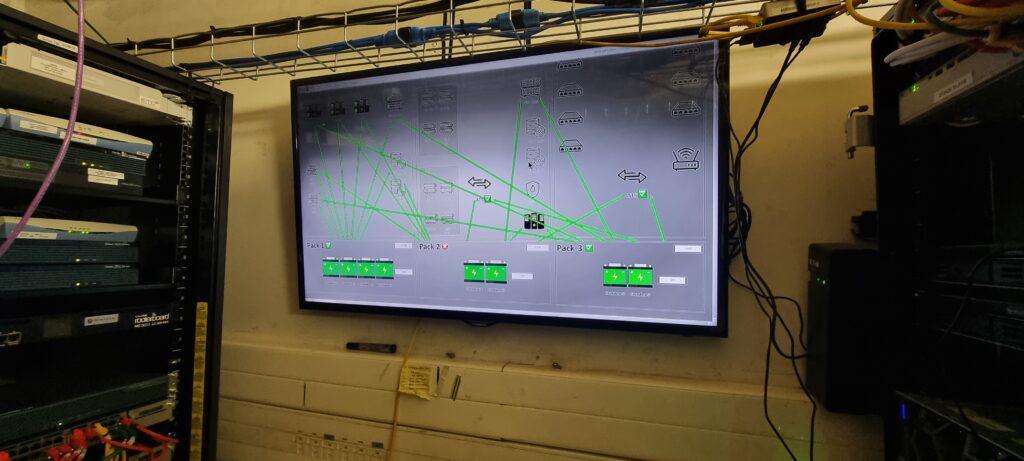

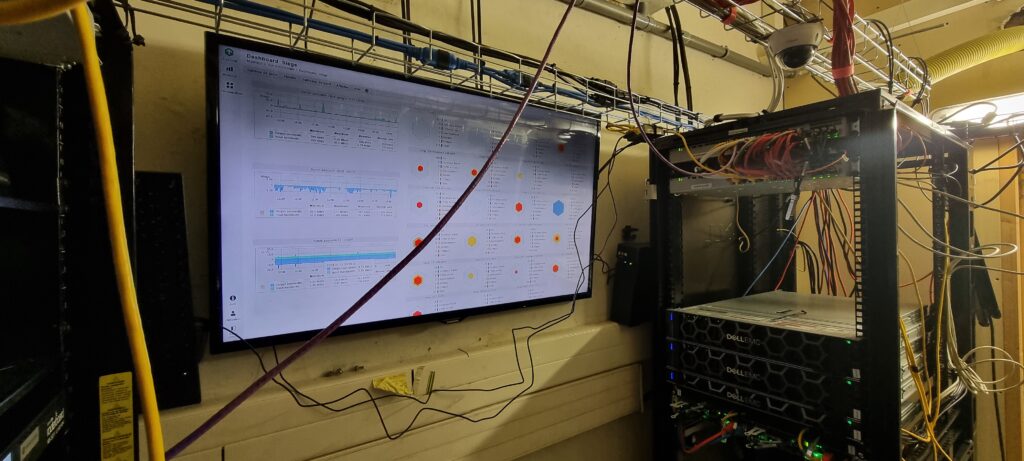

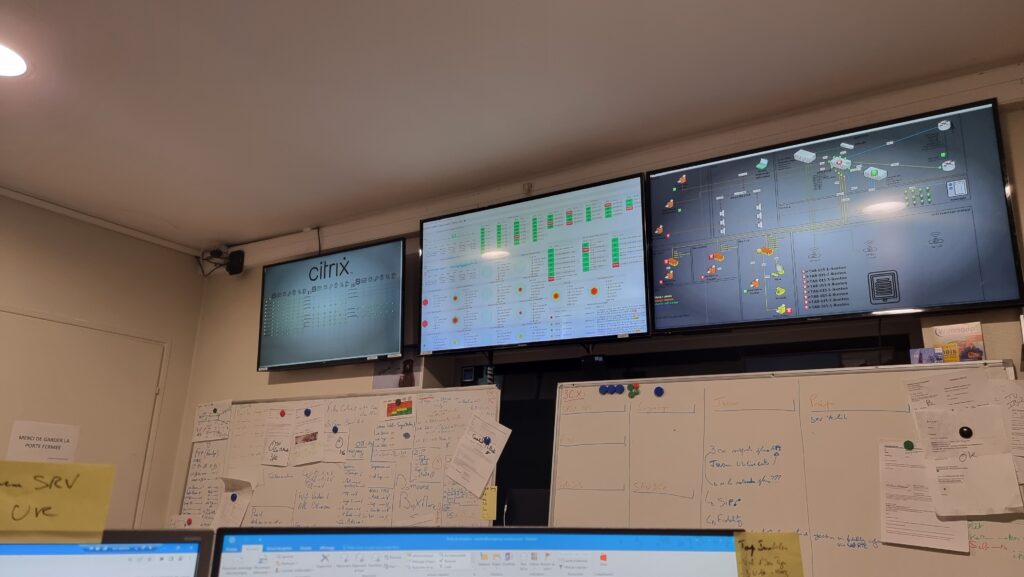

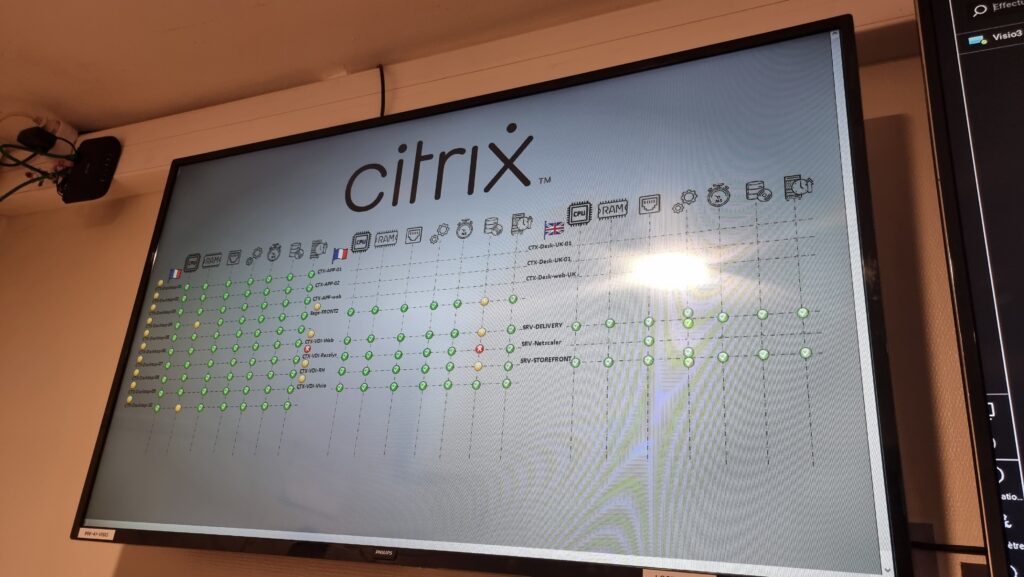

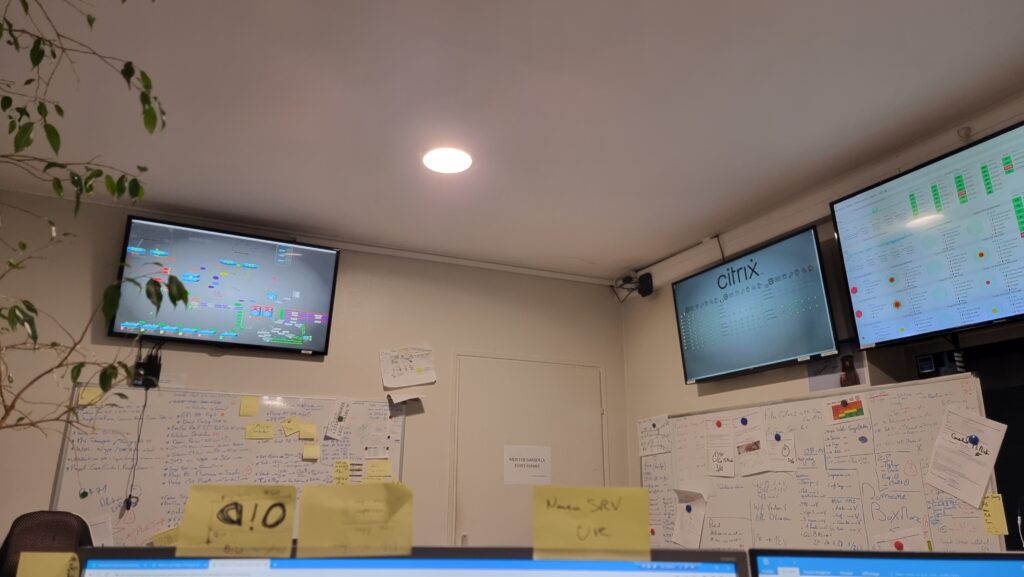

Installation panneau de contrôle CheckMK

Afin d’avoir plus de confort, j’ai fixé une télévision 55 pouces dans la salle serveur en elle-même avec CheckMK qui tourne constamment, afin de voir l’état du réseau, l’état des serveurs physiques.

Chaque numéro de câble y est répertorié, et permet de tout de suite visualiser où est l’erreur.

L’ensemble des serveurs primordiaux y sont présents comme:

- Le serveur mail

- Les serveur Citrix

- Et bien d’autres… ..

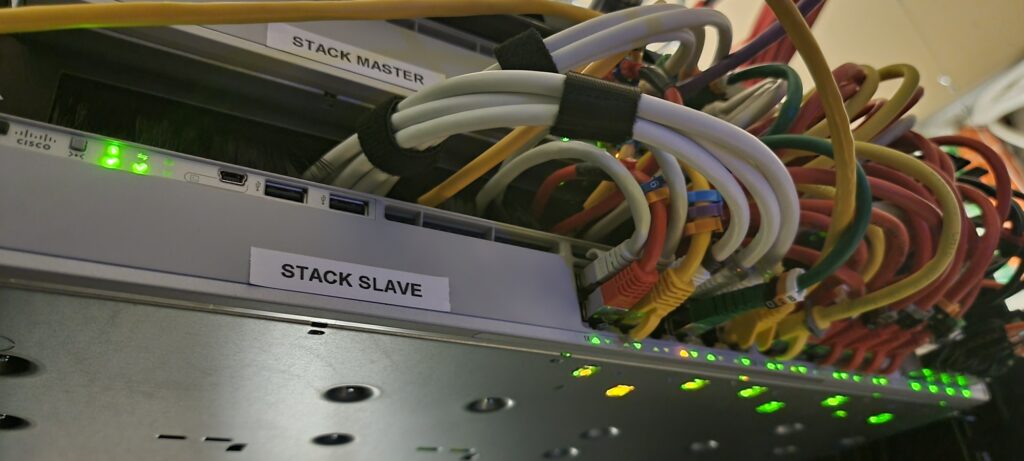

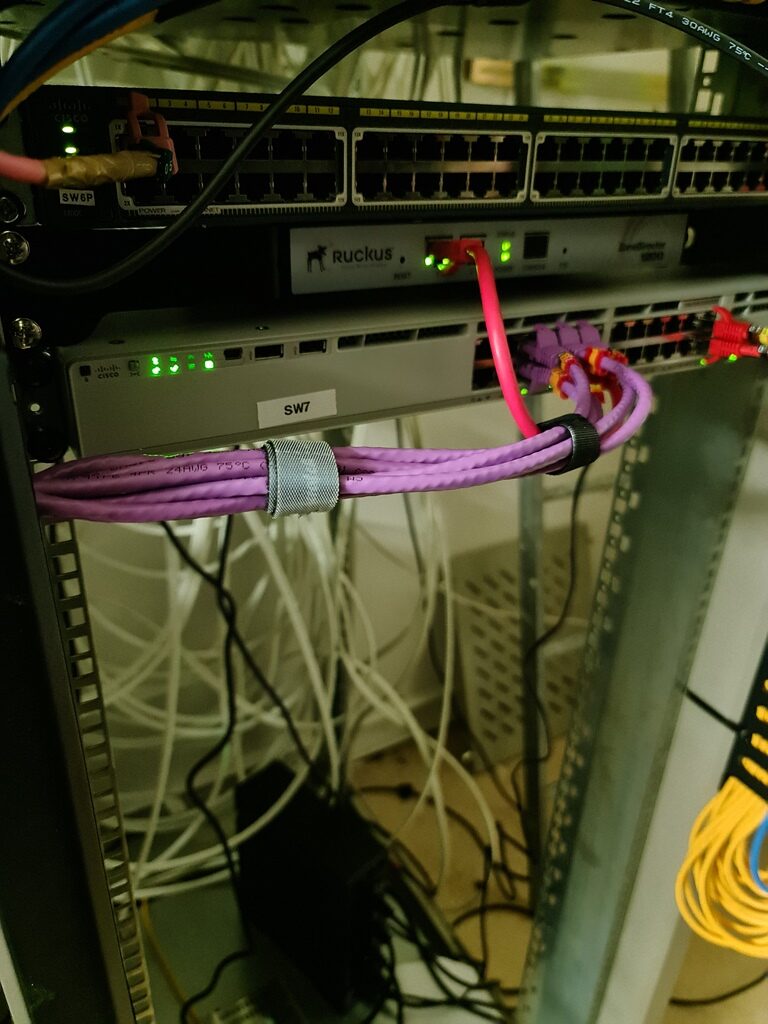

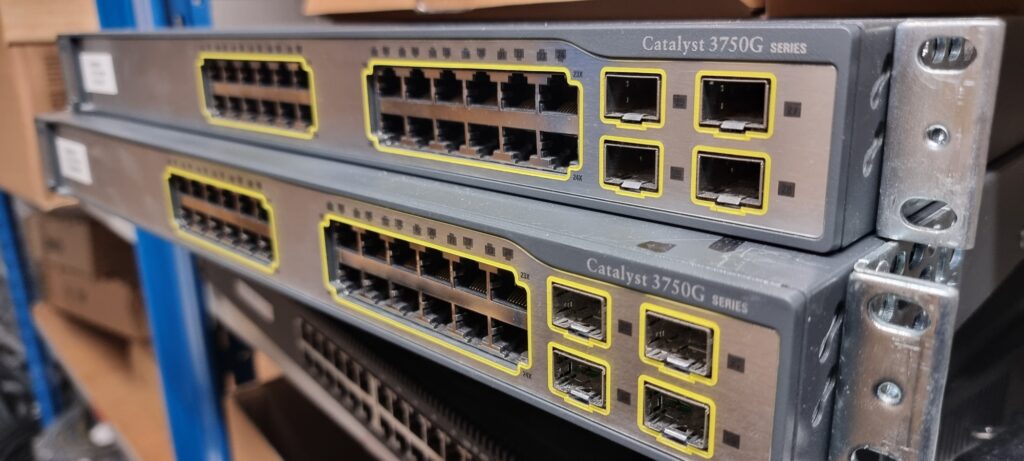

Mise en place d'un nouveau Stack Edge pour les arrivées WAN

Nous avons eu un jour le désagrément de voir un de nos switchs de notre stack principal Edge tombé.

Il m’a fallu reconstituer l’ensemble du stack, le programmer et l’intégrer, tout en évitant une coupure.

J’ai pu le préparer d’avance en atelier ce qui m’a permis de peaufiner ma configuration

Tout tourne depuis 3 ans non-stop sans défaut ..

Mise en place d'un switch 10G pour service consommateur de beaucoup de bandes passantes

Afin d’assurer un vrai confort pour mes utilisateurs gros consommateurs de bandes passantes, comme le service webmaster, ayant besoin d’un accès full giga vers les Synology ou notre serveur DataCore.

J’ai intégré un Cisco 9200, afin d’avoir chaque port en gigabit, et une interconnexion fibre jusqu’à notre cœur, leur permettant ainsi un accès le plus rapide possible. ..

Installation Synology R816 pour sauvegarde immuable

Après avoir installé un cluster pour assurer toutes défaillances physiques, il me fallait assurer aussi la pérennité des données, et se protéger de tout Crypto.

J’ai donc installé un serveur dédié au snap Synology avec des sauvegardes immuables chaque port est en LACP sur mes CISCO en stack. ..

Mise en place des systèmes ATS d'EATON pour les systèmes mono alimentation

Une autre grosse partie a été de dédoubler les alimentations de chaque périphérique en mono-alim, comme sur des routeurs et certains switch.

Pour cela j’ai intégré un ATS par baie, chaque entrée d’alimentation a été répartie sur une grappe d’onduleur isolé, permettant ainsi la maintenance ou l’arrêt d’une des grappes, tout en maintenant l’alimentation de l’ensemble.

J’ai aussi positionné des multiprises en rack de couleurs avec des câbles de couleurs jaune, pour pouvoir cibler les monos alim connectés sur un ATS. ..

Replacement du système ondulé EATON

Une autre grosse particularité de cette salle serveur a été le remplacement total de nos onduleurs, pour cela j’ai profité de mes expériences d’électricien, et fait le calcul de puissance pour chaque baie informatique, j’ai pu donc calculer mes pics d’énergie, et prévoir le matériel adéquate, pour maintenir l’alimentation après coupure.

Actuellement nous avons une autonomie de plus de 2h sur chaque baie, et au moment ou je vous écris nous sommes en train de peaufiner la partie IPM d’EATON ,qui nous permettra un arrêt automatisé avec un serveur dédié. ..

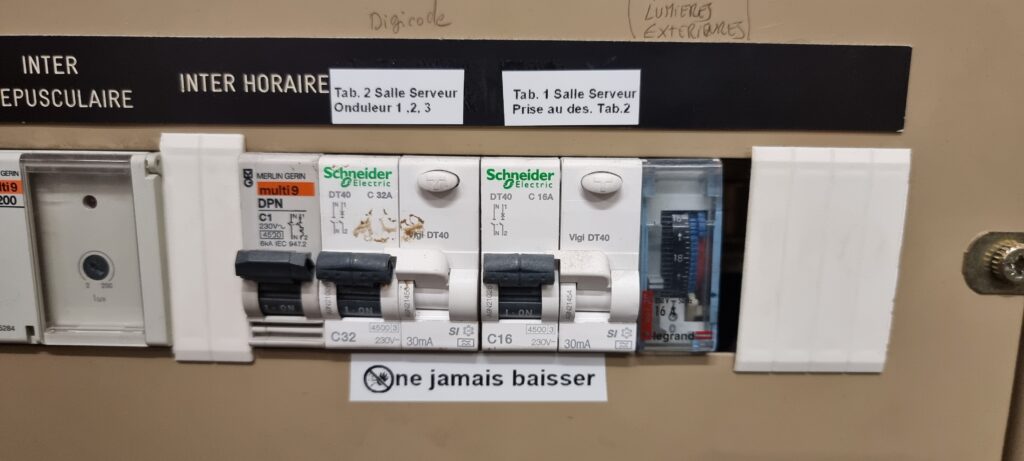

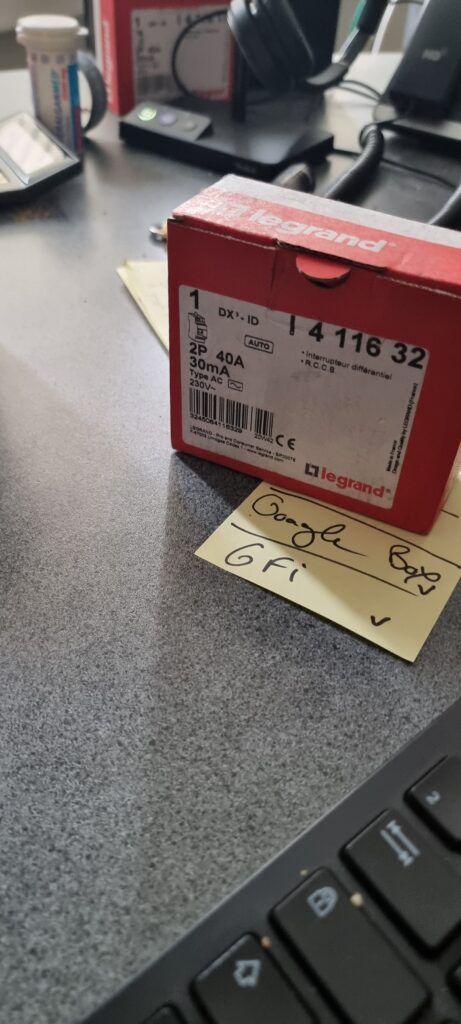

Recâblage du tableau électrique en salle serveur

Un autre très grand moment de cette salle serveur a été la re-confection totale du tableau électrique.

En effet les puissances et le choix des disjoncteurs prévus pour cette salle serveur, étaient sous-dimensionnés, une véritable chance que tout n’ait pas pris feu.

Il n’était pas rare de voir certaines prises disjoncter, j’ai donc retiré un toron du tableau principal à la salle, et refait deux tableaux dédiés, protégés par des différentiels couvrant la puissance nécessaire pour la salle serveur et son évolution future. ..

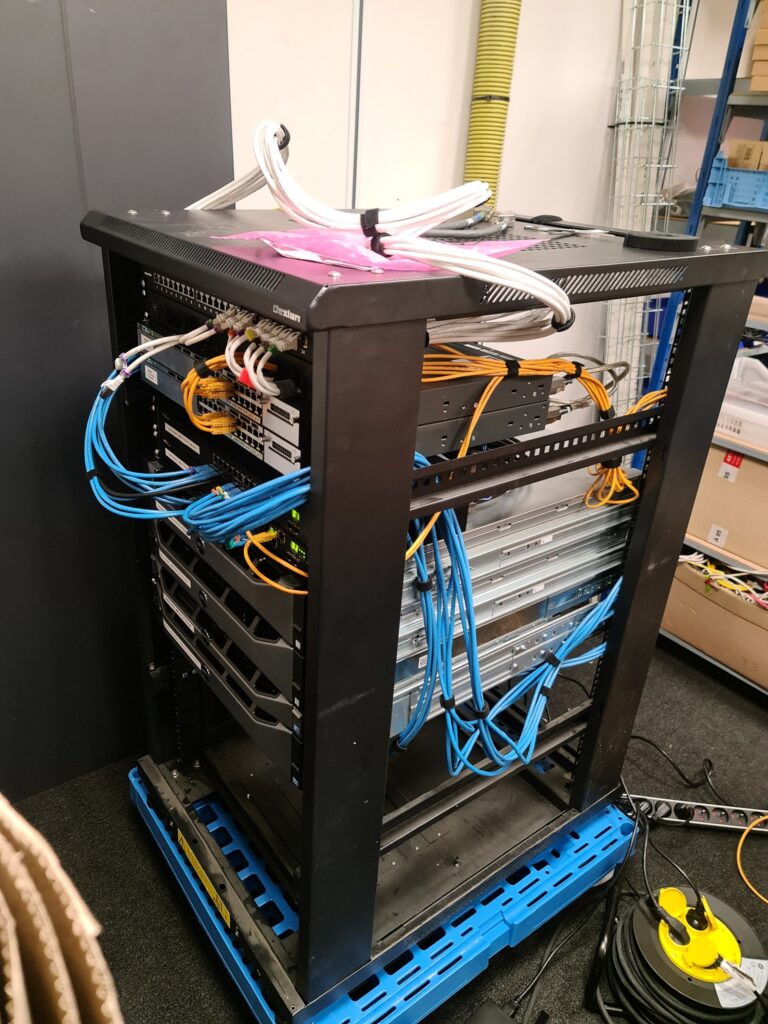

Tirage de câbles réseau inter-salle

Comme vu plus haut j’ai pu avoir la chance de pouvoir mettre en place un PRA et de le configurer de A à Z.

Nous avons dû le placer dans une salle à l’autre bout du bâtiment, mais pour cela et par économie nous avons tiré un janolene à travers le bâtiment pour y faire passer 10 câbles réseau, pour y créer un lien LACP entre nos cœurs CISCO et assurer un très haut débit. ..

changement switch ISCSI

J’ai mis en place des switchs dédiés aux baies de stockage tant sur la production, que sur la partie PRA.

Pour la production cela a été intéressant, car nous étions sur une technologie full fibre optique.

Pour Le PRA nous étions sur une technologie plus classique avec des cuivrés, cependant le principe reste le même. ..

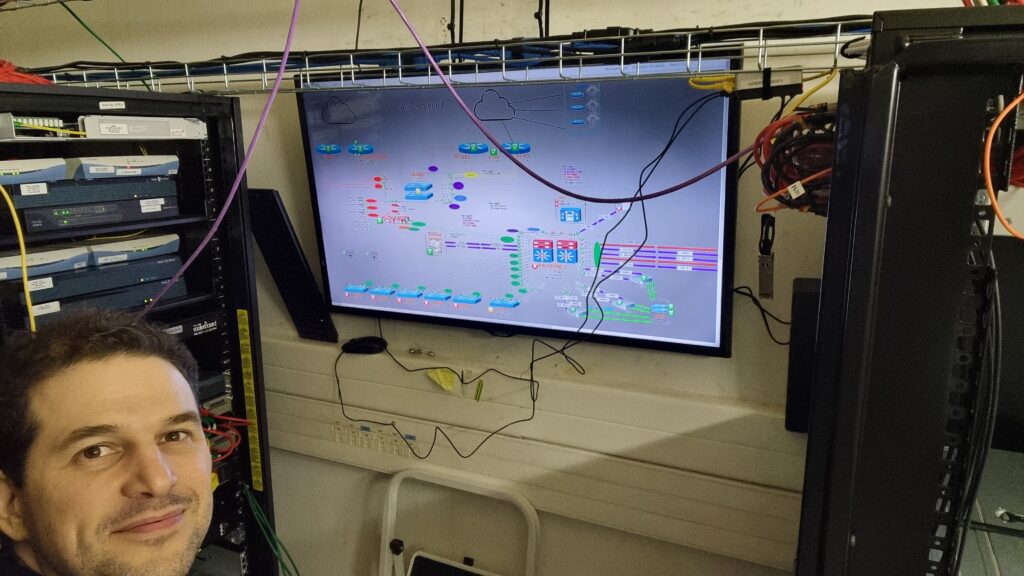

changement du cœur de réseau

La migration du cœur de réseau a été une grosse étape pour nous .

En effet, il a fallu faire cohabiter deux cœurs de réseau, sous deux versions différentes , la salle principale est composée d’un stack Cisco de niveau 3 type 9200, et un 2e cœur composé d’un seul switch en salle PRA pour prendre le relais si besoin.

il a fallu aussi faire cohabiter nos anciens ESXi avec les nouveaux ESXi, en transitant par les fibres optiques du nouveau cœur et de l’ancien.

Il a fallu jouer bien évidemment sur la partie VLAN mais aussi sur la partie HSRP application sur les VLAN et intégrer mes switch Edge, et l’ensemble de mes routes pour assurer un bon routage de sortie.

J’ai entièrement dessiné mon nouveau réseau, et par prudence je me suis fait appuyer par un ingénieur de Résilience afin qu’il atteste mon travail, pour ne pas partir sur de mauvaises directions, l’enjeu étant capital. ..